El web scraping es esencial para recopilar datos, ayudar a las empresas a analizar tendencias, monitorear a los competidores y tomar decisiones informadas. Sin embargo, con la creciente demanda de datos, también existe la necesidad de protección contra la extracción no autorizada, lo que lleva al desarrollo de protecciones de bots raspadores.

Los bots raspadores son herramientas automatizadas que se utilizan para extraer datos, pero también pueden explotarse con fines maliciosos, como robar contenido o sobrecargar servidores. Para prevenir estas amenazas, los sitios web implementan tecnologías anti-scraping. Las herramientas de raspado comunes están diseñadas para imitar el comportamiento humano para recopilar información valiosa, pero los sitios web se han vuelto cada vez más expertos en detectar estas actividades automatizadas.

Comprender cómo eludir estas protecciones de bots raspadores es crucial para el raspado ético. Este artículo cubre cómo funcionan los raspadores web , los métodos de protección comunes y las estrategias éticas para evitarlos. También explora herramientas de web scraping , estudios de casos del mundo real y respuestas a preguntas frecuentes.

Al final, comprenderá la protección contra bots raspadores y cómo navegar de manera responsable.

Si está interesado en obtener más información sobre técnicas avanzadas de raspado web, hemos discutido anteriormente herramientas como Crawl4AI, que ofrece una solución de código abierto para el rastreo inteligente. Además, exploramos la importancia de integrar componentes esenciales en su raspador web para mejorar su efectividad. Para aquellos que buscan aprovechar la IA para el raspado web, nuestra guía sobre el uso de herramientas impulsadas por IA proporciona información valiosa.

Web scraping: cómo funciona y sus aplicaciones

El web scraping es el proceso de extraer datos de sitios web utilizando herramientas automatizadas. Estas herramientas, a menudo denominadas raspadores web o bots, imitan el comportamiento de navegación humano para recopilar información de las páginas web. El proceso generalmente implica enviar solicitudes a un servidor web, recuperar el HTML de la página y analizar el contenido para extraer datos relevantes.

Cómo funcionan los raspadores web

Los raspadores web funcionan mediante el uso de algoritmos específicos para navegar por sitios web, descargar contenido y luego analizarlo en busca de datos útiles. Estas herramientas están diseñadas para emular el comportamiento de un usuario real, como seguir enlaces, hacer clic en botones y completar formularios. La mayoría de las herramientas de raspado web se basan en lenguajes de programación como Python, Java o Node.js, combinados con bibliotecas como BeautifulSoup, Scrapy o Puppeteer para una extracción de datos eficiente.

1. Envío de solicitudes: El raspador envía solicitudes HTTP al servidor del sitio web para recuperar el contenido HTML de la página.

2. Análisis de HTML: una vez que se recupera el contenido, el raspador analiza el HTML para extraer los datos deseados, como texto, imágenes o enlaces.

3. Extracción de datos: después del análisis, el raspador recopila la información en un formato estructurado, como CSV, JSON o bases de datos, para su posterior análisis.

Aplicaciones del Web Scraping

El web scraping se utiliza ampliamente en diversos sectores para diversos fines. Algunas aplicaciones comunes incluyen:

- Investigación de mercado: El raspado de datos de los sitios web de la competencia permite a las empresas realizar un seguimiento de los precios, las promociones y las tendencias del mercado, lo que les brinda una ventaja competitiva.

- SEO: El raspado de datos de las páginas de resultados de los motores de búsqueda (SERP) ayuda a los profesionales de SEO a analizar las clasificaciones de palabras clave, los backlinks y las estrategias de SEO de la competencia. Puede leer más sobre el raspado web SEO aquí.

- Monitoreo de redes sociales: El raspado de plataformas de redes sociales ayuda a las empresas a rastrear las menciones de marca, el análisis de sentimientos y la participación del cliente.

- Comercio electrónico: Los sitios web de comercio electrónico utilizan el raspado web para agregar información de productos de múltiples fuentes, comparar precios y analizar las reseñas de los clientes.

El web scraping se ha convertido en una herramienta indispensable para la toma de decisiones basada en datos. Sin embargo, con el aumento de las medidas de protección contra bots de scraper , es crucial navegar por el proceso de web scraping de manera responsable y garantizar el cumplimiento de los estándares legales y éticos.

Descripción de la protección de bots raspadores

A medida que el web scraping se ha vuelto más frecuente, los sitios web han implementado varias medidas para proteger su contenido y evitar que los bots automatizados extraigan datos. La protección contra bots raspadores implica una variedad de técnicas diseñadas para detectar y bloquear las actividades de raspado, asegurando que solo los usuarios legítimos puedan acceder a los datos.

Técnicas comunes de protección de bots raspadores

Los sitios web utilizan una combinación de soluciones tecnológicas para frustrar los bots de raspado. Estos incluyen:

- Bloqueo de IP: Una de las técnicas más comunes es bloquear las direcciones IP de usuarios sospechosos. Si una dirección IP en particular envía un volumen inusualmente alto de solicitudes en un período corto, puede marcarse como un bot raspador y su acceso puede restringirse.

- CAPTCHA: Los desafíos CAPTCHA (prueba de Turing pública completamente automatizada para diferenciar a las computadoras y los humanos) están diseñados para verificar que un usuario es humano. Estas pruebas a menudo requieren que los usuarios resuelvan acertijos, como identificar personajes distorsionados o seleccionar imágenes específicas. Muchos sitios web utilizan CAPTCHA para evitar que las herramientas de raspado accedan a sus páginas.

- Limitación de velocidad: Los sitios web a menudo limitan la cantidad de solicitudes que un usuario puede realizar dentro de un período de tiempo determinado. Esto se conoce como limitación de velocidad. Si un usuario supera el número permitido de solicitudes, es posible que se bloquee o limite temporalmente.

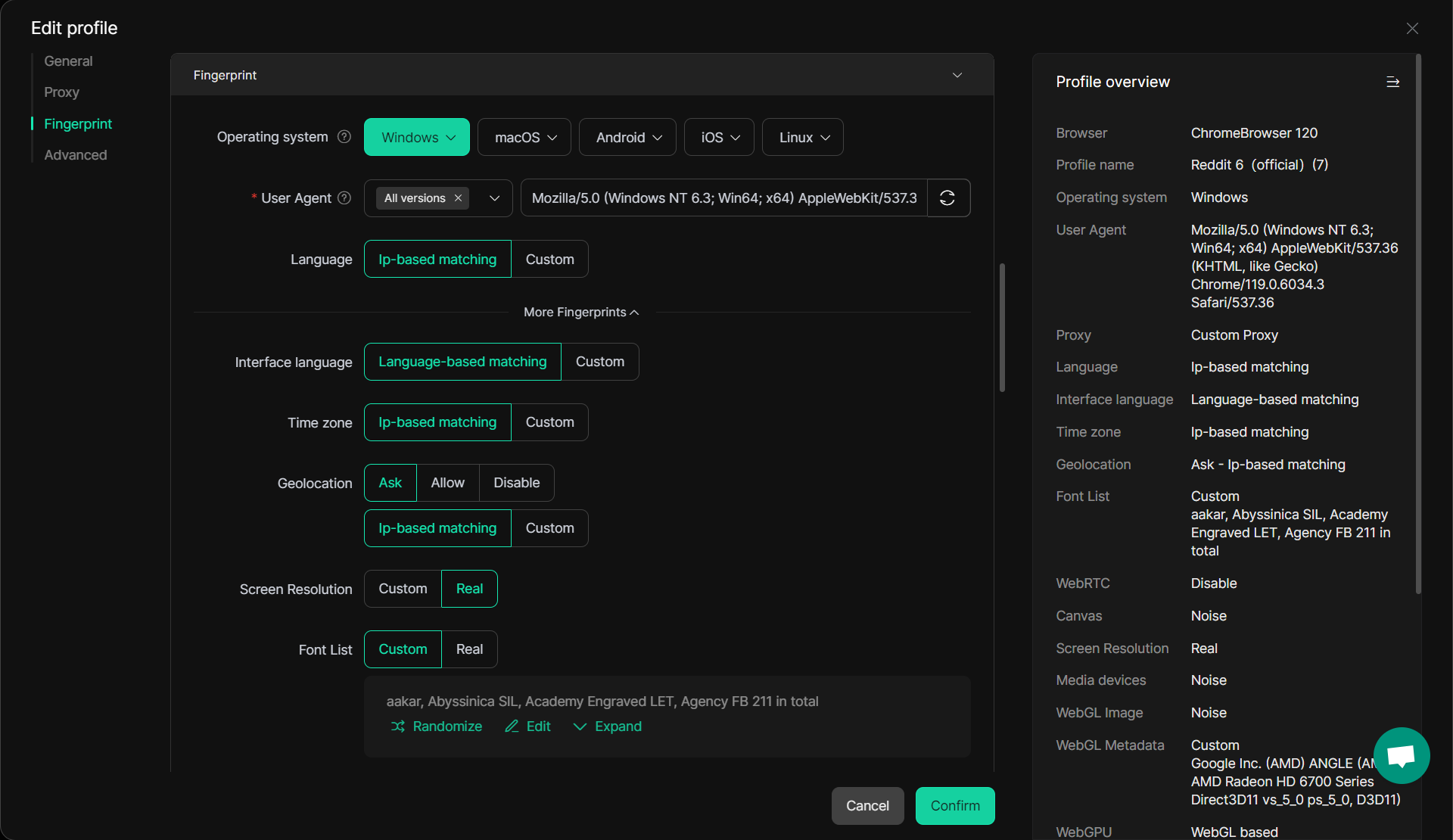

- Huellas dactilares del navegador: Esta técnica recopila información sobre el navegador de un usuario, como la versión, el sistema operativo y los complementos. Si estos detalles coinciden con los patrones conocidos de un bot raspador, el sitio puede bloquear la solicitud.

- Seguimiento de sesiones: Los sitios web pueden rastrear las sesiones de los usuarios a través de cookies u otros identificadores. Si una sesión parece estar automatizada o carece del comportamiento típico del usuario (como el movimiento del mouse o los clics), puede marcarse y bloquearse.

- Honeypots: Un honeypot es una trampa tendida por los sitios web para detectar bots de scraping. Es un campo o enlace oculto con el que los usuarios humanos no interactuarán, pero los raspadores pueden intentar acceder. Si un bot raspador interactúa con el honeypot, se marca como sospechoso.

Por qué son importantes estas protecciones

Estas técnicas son fundamentales para salvaguardar los datos del sitio web, asegurando que solo los usuarios autorizados puedan acceder a él. Sin embargo, estas protecciones también suponen un reto para los web scrapers que necesitan acceder a los datos por motivos legítimos, como estudios de mercado o análisis de la competencia. Comprender cómo funcionan estas protecciones y cómo navegar por ellas es clave para el web scraping ético.

Al emplear estrategias para eludir estas protecciones de manera responsable, los raspadores web pueden continuar recopilando datos valiosos respetando las medidas de seguridad de los sitios web.

Estrategias para eludir la protección de bots raspadores

Si bien los sitios web utilizan varias técnicas para proteger sus datos de los bots de raspado, existen estrategias que los raspadores web éticos pueden usar para eludir estas protecciones. La clave para eludir estas protecciones de scraper bot de manera responsable es imitar el comportamiento legítimo del usuario mientras se mantiene dentro de los límites de las pautas legales y éticas.

1. Uso de proxies

Una de las formas más efectivas de evitar el bloqueo de IP es mediante el uso de proxies. Los proxies actúan como intermediarios entre el raspador y el sitio web, enmascarando la dirección IP real del raspador . Esto dificulta que los sitios web identifiquen y bloqueen la herramienta de raspado.

- Proxies rotativos: Los proxies rotativos cambian la dirección IP con cada solicitud, lo que ayuda a distribuir las solicitudes entre varias IP. Esto reduce la probabilidad de activar bloqueos de IP.

- Proxies residenciales: Los proxies residenciales utilizan direcciones IP reales de redes residenciales reales, lo que hace que sea menos probable que se marquen como bots. Ofrecen un mayor anonimato y son eficaces para eludir el bloqueo geográfico y los CAPTCHA.

2. Emular el comportamiento humano

Los sitios web utilizan técnicas avanzadas para detectar comportamientos no humanos, como clics rápidos, altas tasas de solicitud o falta de interacción con los elementos del sitio. Imitar el comportamiento humano es clave para evitar la detección.

- Retrasos entre solicitudes: la introducción de retrasos aleatorios entre solicitudes simula el comportamiento de navegación humano y evita activar protecciones de limitación de velocidad.

- Simulación de movimiento y clic del mouse: La simulación de movimientos y clics del mouse en páginas web hace que el raspador parezca más humano.

3. Omitir CAPTCHA

Los CAPTCHA son una barrera importante para los raspadores, pero hay formas de evitarlos. Aunque resolver CAPTCHA manualmente es una opción, hay métodos más automatizados disponibles.

- Solucionadores de CAPTCHA: Herramientas como 2Captcha y AntiCaptcha ofrecen servicios para resolver CAPTCHA automáticamente. Envían la imagen CAPTCHA a los trabajadores humanos que la resuelven, lo que permite que los raspadores continúen sus operaciones.

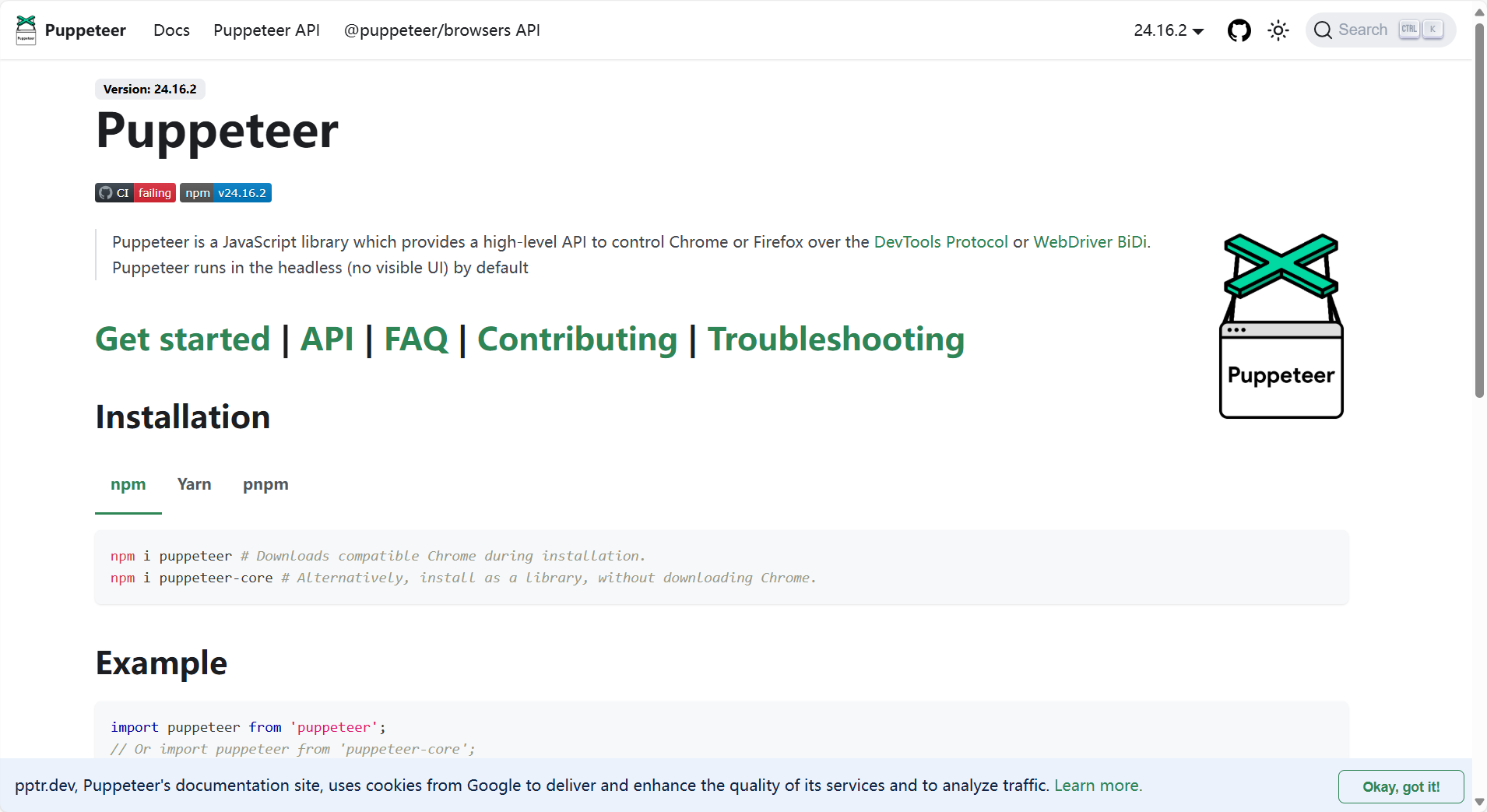

- Navegadores sin cabeza: El uso de navegadores sin cabeza como Puppeteer a veces puede eludir los CAPTCHA al hacer que la actividad de raspado parezca más como un usuario legítimo. Estos navegadores se ejecutan en segundo plano sin necesidad de una GUI.

4. Suplantación de agente de usuario

Los sitios web a menudo rastrean agentes de usuario para identificar bots. Los raspadores pueden evitar la detección falsificando la cadena del agente de usuario para que parezca que la solicitud proviene de un navegador legítimo.

- Rotación de agentes de usuario: Al rotar las cadenas de agentes de usuario para cada solicitud, los raspadores pueden disfrazarse de diferentes dispositivos y navegadores. Herramientas como User-Agent Switcher pueden ayudar a lograr esto.

5. Uso de navegadores compatibles con CAPTCHA

Algunas herramientas de raspado están diseñadas para manejar los desafíos de CAPTCHA en tiempo real. Por ejemplo, DICloak ofrece un navegador anti-detección que ayuda a eludir CAPTCHA y otros mecanismos anti-raspado mediante el uso de técnicas avanzadas para hacer que el raspador parezca un usuario normal.

6. Modo sigiloso

El modo sigiloso se refiere a técnicas avanzadas que implican enmascarar la huella digital del raspador. Esto incluye ocultar la huella digital del raspador, los datos de sesión y los identificadores únicos del dispositivo.

Enmascaramiento de huellas dactilares del navegador: herramientas como DICloak ayudan a aislar las huellas dactilares del navegador, lo que dificulta que los sitios web rastreen y bloqueen los raspadores.

Mediante el uso de estas estrategias, los raspadores web pueden eludir eficazmente los mecanismos comunes de protección de bots raspadores al tiempo que garantizan el cumplimiento y las prácticas éticas. Comprender e implementar estos métodos lo ayudará a mantener el anonimato durante la recopilación de datos y reducir el riesgo de detección y bloqueo.

Herramientas y tecnologías para un raspado web eficaz

Para llevar a cabo el web scraping de manera eficiente y efectiva, se dispone de una variedad de herramientas y tecnologías. Estas herramientas ayudan a automatizar el proceso de raspado, manejar sitios web complejos y garantizar que los raspadores eludan las protecciones sin dejar de ser éticos y cumplir con los estándares legales.

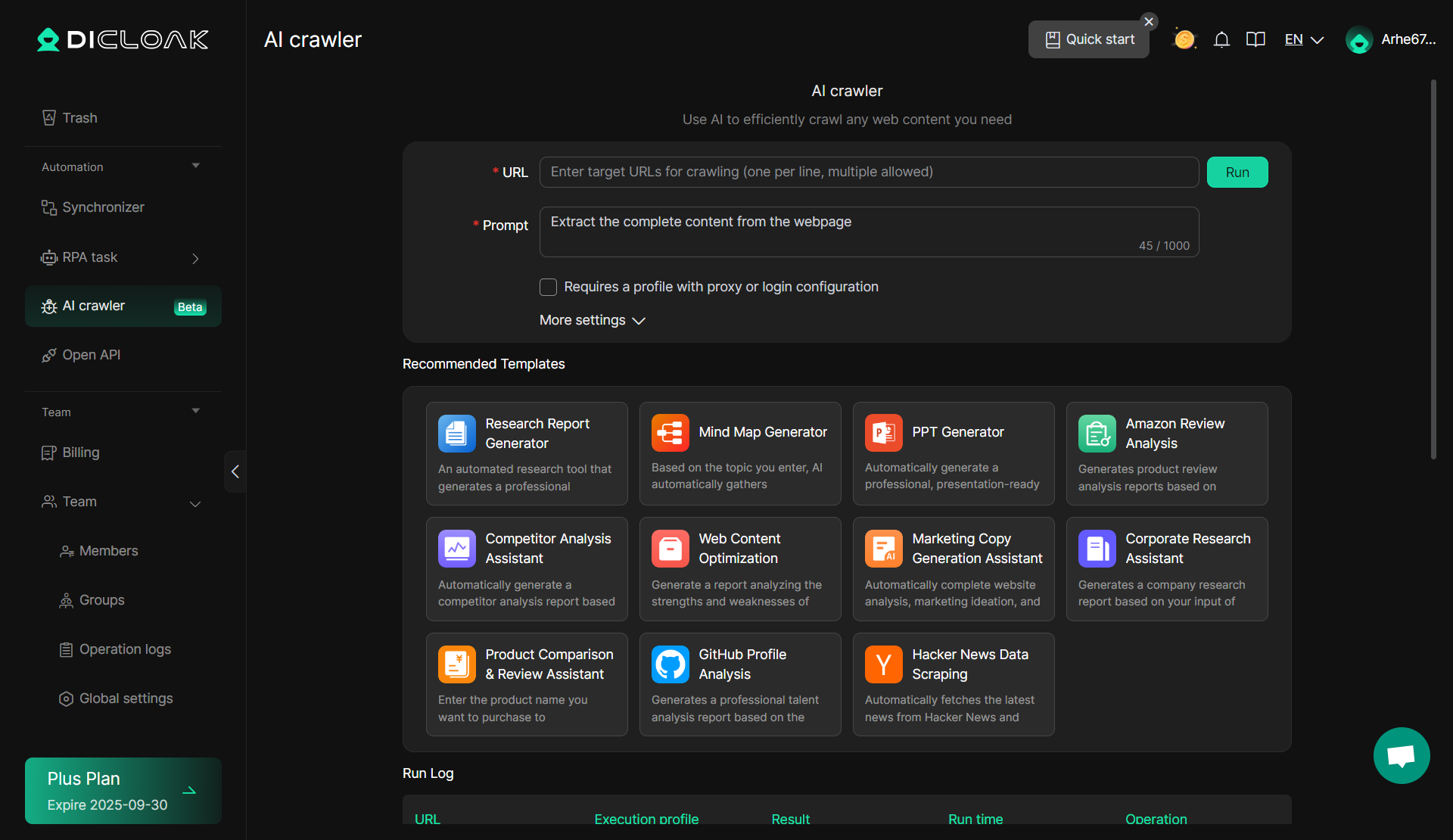

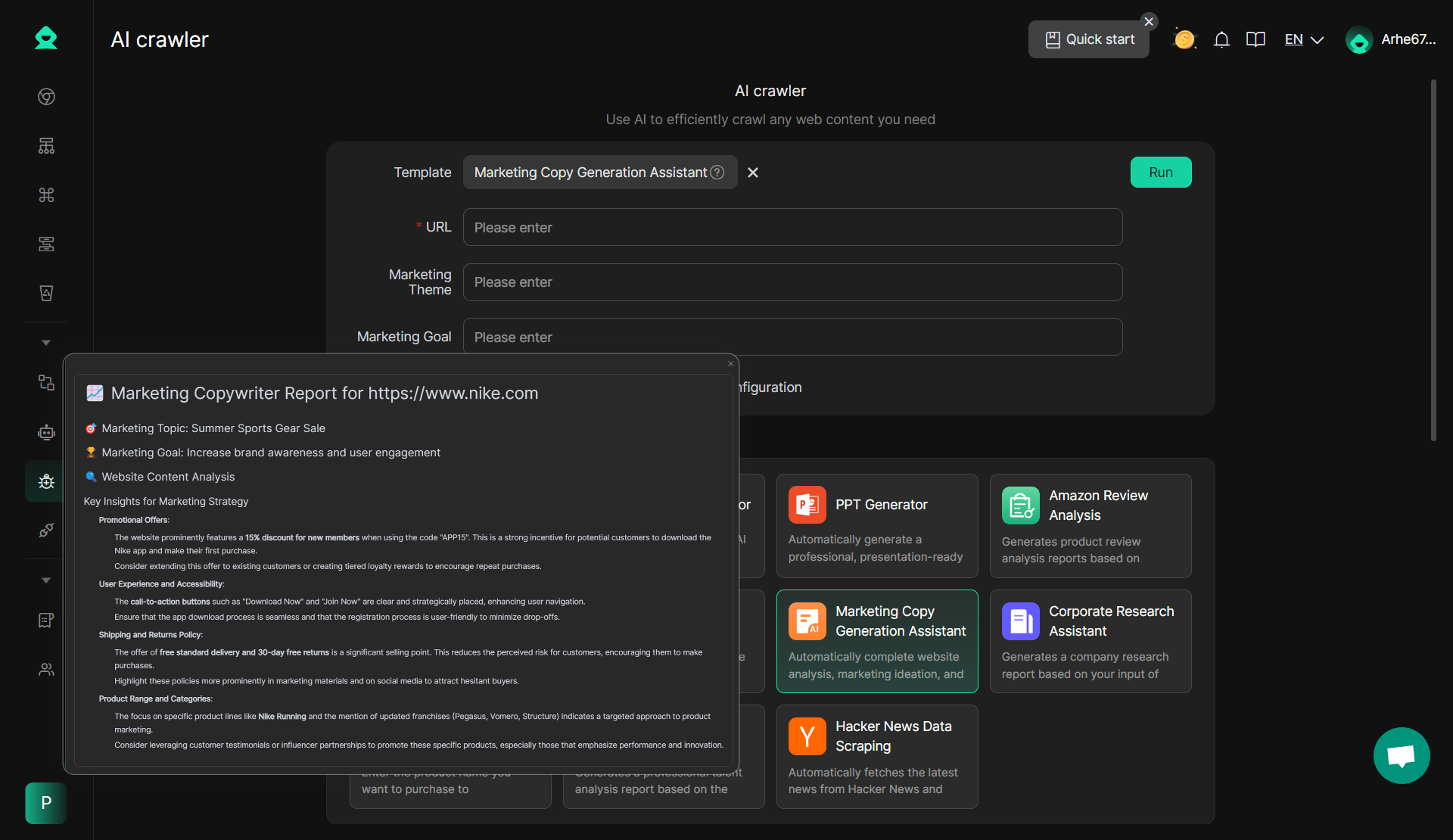

Aquí hay una herramienta simple para las necesidades básicas de raspado y las empresas que buscan una solución fácil de usar que requiere un conocimiento técnico mínimo. El AI Crawler de DICloak es una excelente opción.

DICloak: Rastreador de IA

Una herramienta de raspado notable en la suite de DICloak es AI Crawler. Esta herramienta incorporada aprovecha la inteligencia artificial para mejorar la experiencia de raspado web , especialmente cuando se trata de sitios web dinámicos o complejos. El AI Crawler imita el comportamiento de navegación humano y puede ajustarse a diferentes perfiles web, lo que lo hace muy eficaz para eludir los sistemas de protección de bots raspadores . Puede adaptarse de forma autónoma a diferentes estructuras de sitios web, mejorando la eficiencia y la tasa de éxito de las tareas de scraping.

- Ventajas: El rastreador de IA se ajusta automáticamente a las estructuras cambiantes del sitio web y puede eludir muchas protecciones comunes contra el raspado, como CAPTCHA y el bloqueo de IP. Es altamente eficiente para raspado a gran escala y puede manejar una variedad de tareas complejas sin la necesidad de ajustes manuales constantes.

- No se requiere codificación: simplemente ingrese un mensaje y podrá comenzar a raspar de inmediato, sin necesidad de habilidades de codificación.

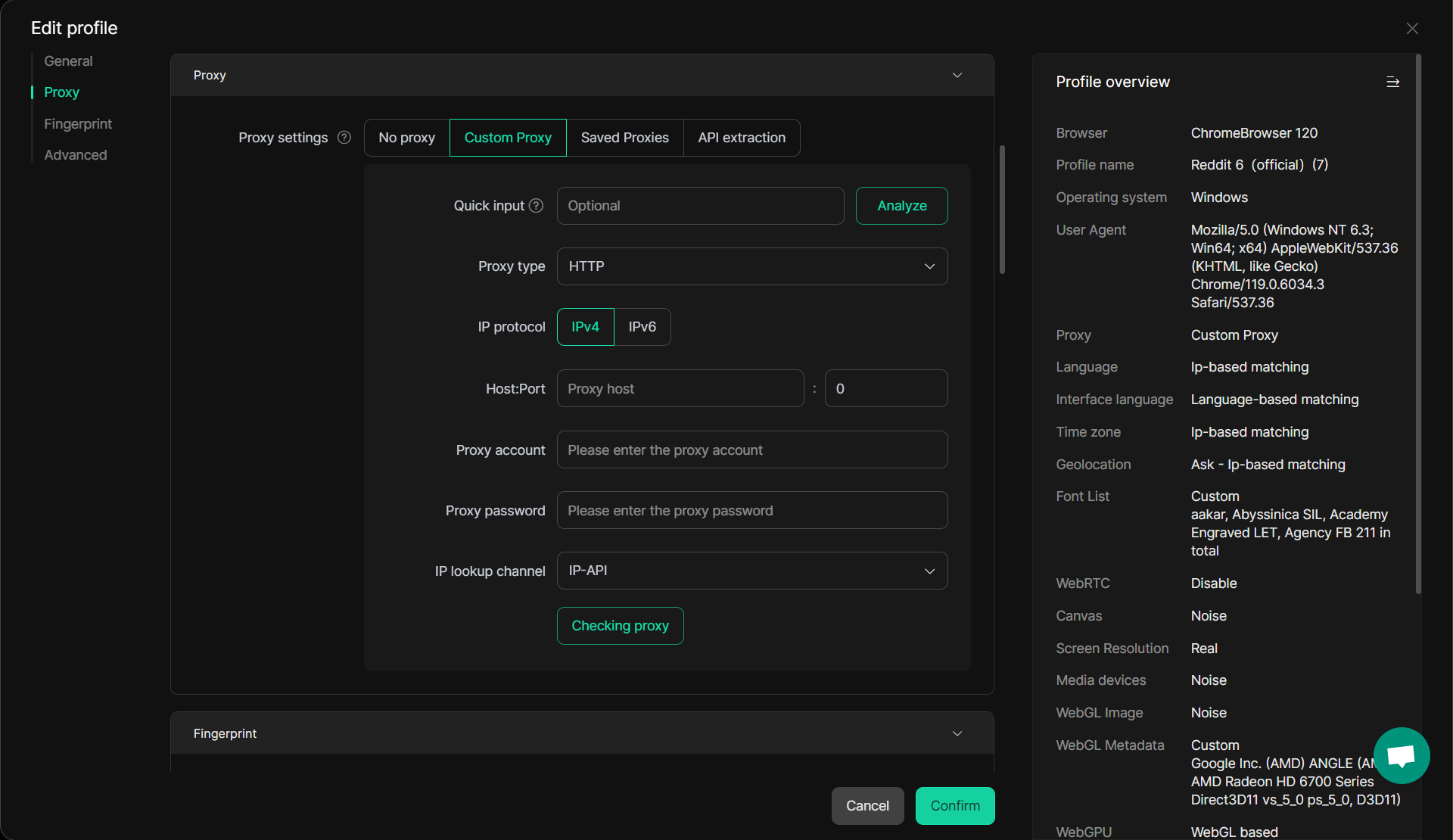

- Configuración de proxy y cuenta: configure fácilmente proxies y cuentas para profundizar en los datos de la plataforma, mejorando la profundidad de su raspado web y evitando la protección de los bots raspadores imitando el comportamiento de navegación humano.

- 11 plantillas prediseñadas: Con 11 plantillas actualizadas, AI Crawler cubre una amplia gama de escenarios y necesidades comerciales, lo que permite una recopilación de datos rápida y eficiente.

- Amplia gama de casos de uso: AI Crawler admite varias aplicaciones comerciales, lo que lo hace ideal para el raspado de datos rápido y simple que mejora la eficiencia operativa.

Plataformas profesionales de raspado web Para necesidades de raspado web más avanzadas y a gran escala, existen varias plataformas de raspado profesional que ofrecen más control, escalabilidad y flexibilidad.

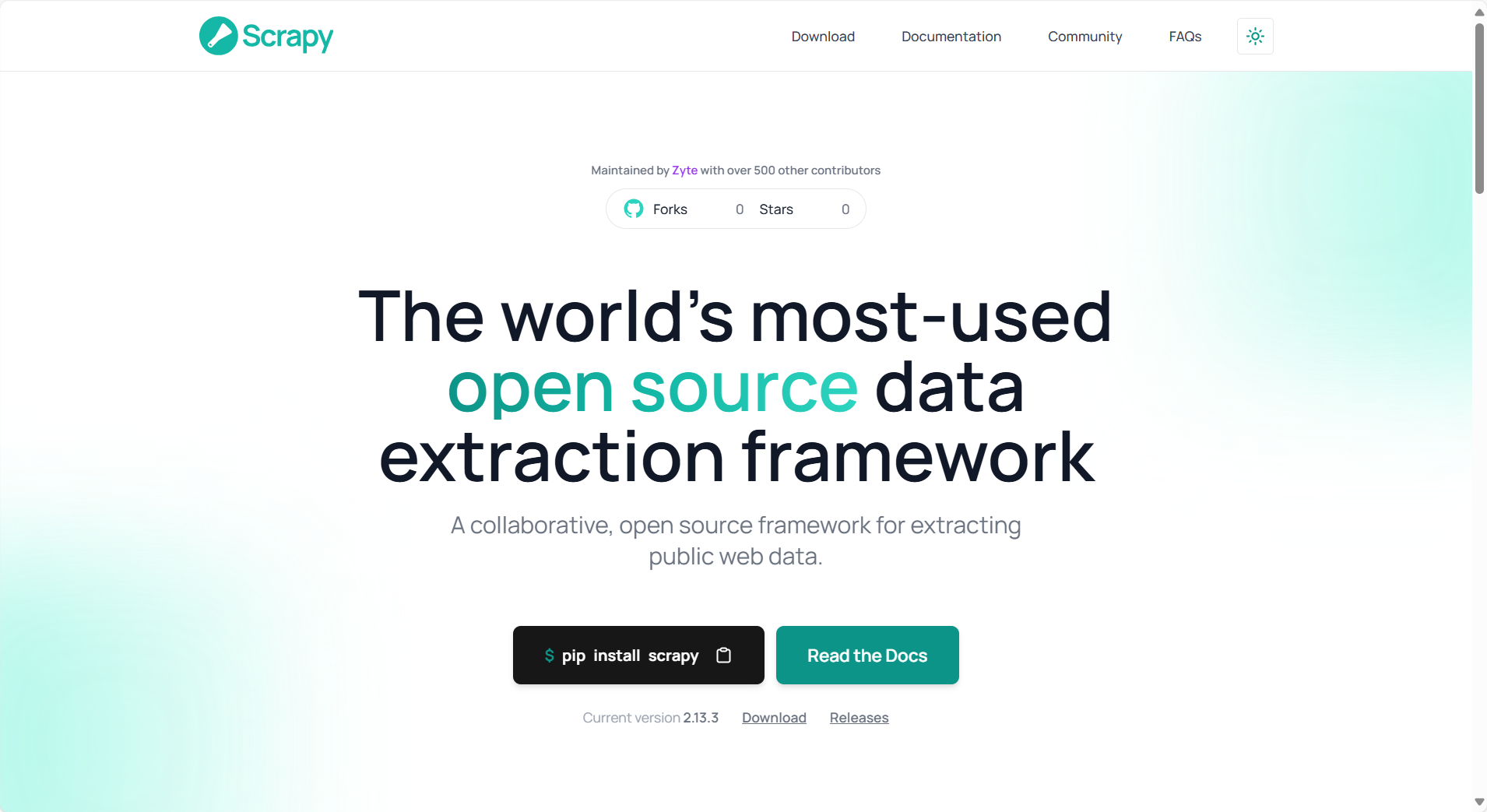

Scrapy es un marco de raspado web de código abierto escrito en Python. Es ampliamente utilizado para raspar sitios web, extraer datos y almacenarlos en varios formatos, como JSON, CSV o bases de datos. Scrapy es particularmente adecuado para tareas de raspado a gran escala, ya que admite el rastreo de varias páginas simultáneamente, y sus funciones integradas, como la rotación de agentes de usuario, pueden ayudar a evitar la detección por parte de los sistemas de protección de bots raspadores . Aquí está el tutorial.

- Ventajas: Rápido, escalable y admite múltiples formatos de datos.

- Desventajas: Requiere conocimientos de programación para configurarlo y usarlo.

BeautifulSoup es una biblioteca de Python que facilita la extracción de datos de archivos HTML y XML. Se utiliza mejor para tareas de raspado más pequeñas, donde los usuarios necesitan extraer datos de una página estática o sitios web simples. Es fácil de configurar y usar, lo que lo hace perfecto para principiantes.

- Ventajas: Fácil de usar, ideal para raspado a pequeña escala.

- Desventajas: Menos eficiente para el raspado a gran escala en comparación con marcos como Scrapy.

Puppeteer es una biblioteca Node.js que proporciona una API de alto nivel para controlar los navegadores Chrome o Chromium sin periféricos. Es útil para raspar sitios web que usan JavaScript o requieren interacciones del usuario (como hacer clic en botones o completar formularios). Puppeteer puede eludir las técnicas comunes de protección de bots raspadores como CAPTCHA y es especialmente efectivo para raspar sitios web dinámicos.

- Ventajas: Maneja sitios web con mucho JavaScript, emula un comportamiento similar al humano.

- Desventajas: Más lento que los métodos tradicionales de raspado.

Selenium es otra herramienta popular para automatizar navegadores. Se puede utilizar con varios lenguajes de programación como Python, Java y C#. Selenium se usa principalmente para probar aplicaciones web, pero también es muy efectivo para tareas de raspado web , especialmente para páginas que requieren interacción.

- Ventajas: Funciona con todos los navegadores web modernos y admite varios idiomas.

- Desventajas: Requiere más recursos y puede ser más lento que las herramientas sin cabeza como Puppeteer.

- Ventajas: Escalable, basado en la nube, admite múltiples casos de uso.

- Desventajas: Puede ser costoso para operaciones a gran escala.

Estas herramientas y tecnologías ofrecen una gama de características que satisfacen diferentes necesidades de web scraping , desde tareas simples de scraping hasta extracción de datos a gran escala. Al elegir la herramienta de raspado adecuada, los raspadores web pueden garantizar una recopilación de datos eficiente, ética y compatible, al tiempo que evitan la protección común de los bots raspadores.

Inconvenientes de estas herramientas y cómo mejorar con DICloak

Si bien hay muchas herramientas y tecnologías disponibles para el raspado web, vienen con su propio conjunto de limitaciones. DICloak, con sus funciones avanzadas de antidetección, puede ayudar a superar muchos de estos desafíos, haciendo que el raspado web sea eficiente y seguro.

1. Problemas de bloqueo de IP y proxy

Muchas herramientas de raspado web se basan en proxies para eludir las restricciones basadas en IP. Sin embargo, el uso de proxies a veces puede conducir a un rendimiento más lento o a una mayor detección por parte de los mecanismos de protección de bots raspadores . Es posible que las soluciones de proxy tradicionales no puedan disfrazar eficazmente las actividades de raspado, especialmente cuando se envían varias solicitudes desde la misma dirección IP.

Solución DICloak: DICloak resuelve este problema al ofrecer una configuración avanzada de proxy, admitir proxies rotativos e IP residenciales para garantizar una navegación fluida y sin problemas. Su capacidad de conmutación de IP en tiempo real dificulta que los sitios web detecten y bloqueen los raspadores. Con DICloak, puede administrar múltiples cuentas y tareas de raspado web sin activar medidas de seguridad como el bloqueo de IP.

2. Detección y huellas dactilares del navegador

La mayoría de las herramientas tradicionales de raspado web luchan con las huellas dactilares del navegador, una técnica utilizada por los sitios web para identificar y bloquear bots. Estas herramientas suelen utilizar cadenas estáticas de agente de usuario o direcciones IP, lo que facilita a los sitios web detectar y bloquear los intentos de raspado.

Solución DICloak: DICloak proporciona un sofisticado aislamiento de huellas dactilares del navegador, lo que garantiza que cada sesión de raspado aparezca como un usuario único con diferentes huellas digitales. Al enmascarar identificadores como la resolución de pantalla, las fuentes y los complementos, DICloak imita el comportamiento de navegación humano, lo que reduce las posibilidades de detección. Este aislamiento de huellas dactilares es especialmente útil para eludir sofisticadas tecnologías anti-scraping. Lea más sobre cómo DICloak ayuda con el aislamiento de huellas dactilares aquí.

Además de las soluciones efectivas que DICloak proporciona para los tres riesgos mencionados anteriormente, el DICloak AI Crawler es el complemento perfecto, lo que lo hace aún más potente. Cuando trabaja con tareas complejas y profesionales de raspado web , DICloak lo ayuda a reducir los riesgos. Pero cuando necesita extraer datos de fuentes simples de manera rápida y eficiente, DICloak interviene para mejorar su eficiencia.

DICloak AI Crawler: seguridad y comodidad mejoradas

AI Crawler de DICloak puede raspar datos a gran escala de manera segura y efectiva sin activar los sistemas de detección. Su capacidad para ajustarse de forma autónoma a las estructuras cambiantes del sitio web lo hace altamente eficiente para sitios dinámicos, lo que reduce el riesgo de detección y bloqueo.

Características de DICloak AI Crawler:

- No se requiere codificación: simplemente ingrese un mensaje para comenzar a raspar de inmediato, sin necesidad de codificación.

- Configuración de proxy y cuenta: Configure fácilmente proxies y cuentas para profundizar en los datos de la plataforma, mejorando la profundidad de su web scraping.

- 11 plantillas prediseñadas: Con 11 plantillas actualizadas, AI Crawler cubre una amplia gama de escenarios y necesidades comerciales, lo que permite una recopilación de datos rápida y eficiente.

- Amplia gama de casos de uso: AI Crawler admite varias aplicaciones comerciales, lo que lo hace ideal para el raspado de datos rápido y simple que mejora la eficiencia operativa.

Preguntas frecuentes sobre la omisión de la protección contra bots raspadores

P1: ¿Qué es la protección contra bots raspadores?

La protección contra bots raspadores se refiere a las técnicas que utilizan los sitios web para evitar que los bots automatizados extraigan datos. Estos incluyen medidas como el bloqueo de IP, los desafíos de CAPTCHA, la huella digital del navegador y la limitación de velocidad. Los sitios web implementan estas protecciones para garantizar que solo los usuarios legítimos puedan acceder a su contenido y datos, protegiéndolos contra actividades maliciosas de raspado.

P2: ¿Cómo puedo eludir la protección contra bots raspadores de forma segura?

Para eludir la protección de bots raspadores de manera responsable, puede usar estrategias como rotar proxies, emular el comportamiento humano (por ejemplo, agregar retrasos entre solicitudes), falsificar cadenas de agente de usuario y usar solucionadores CAPTCHA. Estos métodos le permiten realizar web scraping de una manera que minimiza el riesgo de detección y bloqueo, asegurando el cumplimiento de los estándares legales y éticos.

P3: ¿Qué herramientas son las mejores para el raspado web?

Hay varias herramientas de raspado disponibles para un raspado web efectivo, que incluyen:

- Scrapy: Un marco rápido, escalable y potente para el raspado a gran escala.

- BeautifulSoup: Una herramienta simple para tareas de raspado más pequeñas.

- Titiritero: Lo mejor para raspar sitios web con mucho JavaScript.

- Selenium: Ideal para páginas que requieren interacción del usuario.

- DICloak: Un navegador anti-detección que mejora la eficiencia del raspado al eludir los sistemas comunes de protección de bots raspadores .

P4: ¿Cómo ayuda DICloak con la protección de bots raspadores?

DICloak ayuda a evitar la protección de los bots raspadores al aislar las huellas dactilares del navegador, rotar las IP y ofrecer configuraciones de proxy avanzadas. Permite a los raspadores web mantener el anonimato al evitar que los sitios web detecten actividades de raspado. Además, DICloak proporciona administración de sesiones y puede simular interacciones similares a las humanas, lo que reduce la probabilidad de ser bloqueado o marcado como bot.

P5: ¿Se pueden utilizar los bots raspadores con fines éticos?

Sí, los bots de raspado se pueden usar éticamente para fines legítimos, como investigación de mercado, análisis de la competencia y agregación de datos. Sin embargo, es importante seguir las pautas legales, respetar los términos de servicio del sitio web y garantizar el cumplimiento de las medidas de protección de los bots raspadores . El raspado web ético siempre debe respetar la privacidad y seguridad de los datos que se extraen.

P6: ¿Por qué es importante gestionar las sesiones de scraping?

La gestión de sesiones y cookies es crucial en el web scraping para garantizar que cada sesión se trate como un usuario único. La gestión adecuada de las sesiones evita que los sitios web rastreen y bloqueen los raspadores en función de las cookies compartidas o los datos de la sesión. DICloak sobresale en la gestión de sesiones, asegurando que los raspadores web puedan acceder a los datos sin activar medidas de seguridad como prohibiciones de IP o CAPTCHA.

Conclusión

En conclusión, el web scraping se ha convertido en una poderosa herramienta para recopilar datos, lo que permite a las empresas obtener información, rastrear a los competidores y mejorar la toma de decisiones. Sin embargo, con el auge de las tecnologías de protección contra bots raspadores , es esencial navegar por el proceso de raspado de manera responsable. Herramientas como DICloak brindan soluciones avanzadas para eludir protecciones comunes como el bloqueo de IP, CAPTCHA y huellas dactilares del navegador, lo que permite que los raspadores web operen con mayor eficiencia y seguridad.

Mediante el uso de AI Crawler de DICloak y otras funciones avanzadas, los raspadores no solo pueden reducir los riesgos asociados con la detección y el bloqueo, sino también agilizar el proceso de raspado, lo que permite una recopilación de datos más rápida y precisa. Ya sea que esté abordando tareas complejas de raspado o manejando necesidades de extracción de datos más simples, DICloak garantiza el cumplimiento de los estándares legales y éticos al tiempo que mejora la productividad general.

Dado que el web scraping sigue desempeñando un papel crucial en la toma de decisiones basada en datos, comprender cómo trabajar con los sistemas de protección de bots scraper y utilizar las herramientas adecuadas será clave para garantizar prácticas de scraping efectivas y responsables.

Herramientas gratuitas

Complemento de cookies

Generador UA

Generador de direcciones MAC

Generador de IP

Lista de direcciones IP

Generador de código 2FA

Reloj Mundial

Cheque Anónimo

Verificador de Proxy

Verificador de anuncios de Facebook

Raspado web con IA

Herramientas SMM Gratis

Verificador de Sombreado de Twitter