El web scraping se ha convertido en una herramienta vital en todas las industrias, impulsando el análisis competitivo, la investigación de mercado, el seguimiento de precios y más. Pero a medida que el raspado se generaliza, también lo hacen las contramedidas diseñadas para bloquearlo. Los sitios web están cada vez más equipados con sistemas anti-bot que monitorean el tráfico entrante y filtran cualquier cosa que parezca automatizada o sospechosa.

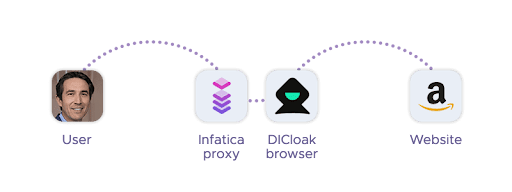

Esto crea un desafío cada vez mayor para los profesionales de datos: ¿cómo extraer información de manera confiable sin ser detectado o bloqueado? En este artículo, exploraremos cómo los navegadores anti-detección como DICloak juegan un papel clave en esta estrategia, cómo se integran con soluciones proxy como las que ofrece Infática, y qué mejores prácticas ayudan a mantener sus operaciones conformes y efectivas.

Las defensas anti-bots están evolucionando

El web scraping se ha convertido en una parte fundamental de las operaciones digitales, desde la agregación de precios hasta la inteligencia de mercado, pero a medida que mejoran las técnicas de scraping, también lo hacen las defensas diseñadas para detenerlas. Los sitios web modernos despliegan un arsenal cada vez mayor de mecanismos anti-bot que pueden detectar y bloquear fácilmente las herramientas de raspado tradicionales.

Estas defensas van mucho más allá de la limitación básica de la velocidad de IP. Los sistemas sofisticados analizan las huellas dactilares del navegador, monitorean los patrones de movimiento del mouse y rastrean los comportamientos de carga de recursos para identificar la actividad automatizada. Los navegadores sin cabeza, incluso aquellos basados en motores de usuario reales como Chromium o Firefox, a menudo llevan signos reveladores de automatización, como complementos faltantes, tamaños de ventana inusuales o cadenas de agente de usuario predecibles.

La huella digital juega un papel particularmente crucial: los sitios web pueden recopilar docenas de puntos de datos (por ejemplo, representación de lienzo, WebGL, zona horaria, idioma, detalles del sistema operativo) para crear una firma de navegador única. Cuando esa firma se repite en varias solicitudes, genera sospechas y, por lo general, resulta en un bloqueo.

En este entorno, las herramientas de raspado tradicionales se quedan cortas. Evitar la detección requiere no solo rotar las direcciones IP, sino también rotar las identidades, hasta el nivel de las características de hardware y software. Ya no basta con enviar solicitudes HTTP o utilizar un navegador headless; El scraping exitoso requiere una estrategia de pila completa que reduzca su visibilidad como bot.

El papel de los navegadores anti-detección en el web scraping

Ahí es donde entran en escena los navegadores anti-detección como DICloak: son capaces de imitar a los usuarios genuinos en todas las capas de interacción. Eso incluye el uso de direcciones IP limpias y rotativas, huellas dactilares realistas del navegador y patrones de comportamiento similares a los humanos.

Los navegadores antidetección son herramientas especialmente diseñadas para ayudar a los usuarios a aparecer como visitantes genuinos y únicos al acceder a sitios web. Para los profesionales del web scraping, sirven como una poderosa alternativa a las herramientas de automatización tradicionales al ofrecer un control granular sobre las huellas dactilares del navegador, los parámetros de red y las señales de comportamiento.

A diferencia de los navegadores headless estándar, que a menudo utilizan configuraciones predeterminadas o en blanco, los navegadores anti-detección permiten a los usuarios manipular y aleatorizar una amplia gama de atributos. Estos incluyen la cadena de agente de usuario, la resolución de la pantalla, las fuentes del sistema, la zona horaria, los detalles de la CPU y la GPU, e incluso los datos de huellas digitales de WebGL o canvas. Al hacerlo, crean perfiles de navegador convincentes y no repetitivos que reflejan a los usuarios reales con alta fidelidad.

Muchos navegadores antidetección también admiten perfiles persistentes y almacenamiento de sesión, lo que los hace ideales para tareas de raspado que requieren credenciales de inicio de sesión, administración de cookies o navegación de varios pasos. Combinados con herramientas de automatización como Puppeteer o Selenium (a través de plugins o API), los navegadores anti-detección permiten un scraping escalable y sigiloso tanto a nivel pequeño como empresarial.

Combinación de navegadores anti-detección con proxies

Incluso la huella digital del navegador más sofisticada no puede eludir los sistemas anti-bot por sí sola: sin la infraestructura de red adecuada, los intentos de raspado seguirán generando banderas rojas. Es por eso que emparejar como DICloak con proxies de alta calidad es esencial para cualquier operación seria de web scraping. Pero, ¿qué son los proxies?

Los proxies sirven como primera línea de defensa al enrutar el tráfico a través de direcciones IP alternativas, lo que ayuda a evitar límites de velocidad y prohibiciones de IP. Sin embargo, no todos los proxies son iguales: los sitios web a menudo pueden detectar y bloquear proxies de baja calidad o mal configurados, especialmente aquellos con patrones sospechosos o reputaciones de IP compartidas.

Cuando se usan juntos, los proxies y los navegadores anti-detección forman un dúo sigiloso y adaptable. Mientras que el navegador antidetección maneja la huella digital del lado del navegador, simulando el comportamiento real del usuario, el proxy maneja la identidad del lado de la red, lo que permite que los usuarios parezcan como si se estuvieran conectando desde diferentes países, regiones o incluso redes móviles.

Esta combinación es especialmente eficaz para casos de uso como el scraping localizado, la creación de cuentas o el acceso a contenido restringido geográficamente. Por ejemplo, los proxies residenciales rotativos se pueden combinar con perfiles de navegador únicos para simular miles de usuarios genuinos de diferentes hogares.

En Infatica, ofrecemos un conjunto completo de soluciones de proxy, incluidos proxies residenciales, de centros de datos y móviles, que se integran a la perfección con los navegadores anti-detección. Diseñados para ofrecer rendimiento y estabilidad, nuestros proxies ayudan a los profesionales del scraping a evitar bloqueos, reducir el tiempo de inactividad y garantizar un acceso fiable a los datos a escala.

Aplicaciones en el mundo real

La combinación de navegadores anti-detección y proxies de alta calidad desbloquea una amplia gama de potentes casos de uso de web scraping en todas las industrias. Echemos un vistazo más de cerca a los escenarios comunes del mundo real en los que este emparejamiento tecnológico resulta invaluable:

Monitoreo de precios en todas las regiones

Las empresas de comercio electrónico y los analistas confían en los navegadores anti-detección para raspar los precios de los mercados en línea sin desencadenar restricciones geográficas o prohibiciones de IP. Al emparejar proxies rotativos con perfiles de navegador únicos, los scrapers pueden simular usuarios locales en varios países y comparar precios o descuentos regionales.

Agregación de viajes e inteligencia de tarifas

Las plataformas de reserva de vuelos y hoteles suelen ofrecer diferentes contenidos en función de la ubicación del usuario y de la configuración del navegador. Con un navegador anti-detección, los raspadores pueden variar las huellas dactilares, mientras que los proxies simulan solicitudes de diferentes ciudades o países, lo que ayuda a recopilar datos de viaje precisos y específicos de la ubicación.

Scraping de SERP y seguimiento SEO

Los motores de búsqueda personalizan los resultados en función de la ubicación, el dispositivo y el comportamiento anterior. Raspar las SERP sin detección requiere una identidad de navegador convincente y un enrutamiento de proxy confiable. Los navegadores antidetección permiten a los scrapers emular a los usuarios de escritorio o móviles, mientras que los proxies desbloquean resultados locales de regiones globales.

Generación de leads y recopilación de datos públicos

Los profesionales del marketing B2B utilizan el scraping para recopilar datos de contacto, reseñas y listados de plataformas como directorios o bolsas de trabajo. Las configuraciones antidetección permiten sesiones persistentes y autenticadas, incluso en sitios con acceso para inicio de sesión, mientras que los proxies garantizan que las solicitudes no se originen en la misma IP.

Verificación de anuncios y detección de fraudes

Las marcas y las empresas de tecnología publicitaria utilizan el scraping para verificar que los anuncios aparezcan correctamente en todas las ubicaciones geográficas y dispositivos. La combinación de perfiles antidetección con proxies específicos de la ubicación permite obtener una vista previa realista de cómo los usuarios experimentan las campañas, y ayuda a detectar redireccionamientos ocultos o fraude de clics.

Un enfoque unificado para el raspado sigiloso

Los sistemas antibot modernos no dependen de una sola señal, sino que analizan todo, desde su dirección IP hasta la huella digital de su navegador y el comportamiento del usuario. Para eludir de forma fiable estas defensas, las operaciones de raspado deben aplicar sigilo en todos los niveles:

- Identidad de la red: Utilice proxies giratorios de alta calidad para evitar la detección y acceder a datos con restricciones geográficas. Infatica proporciona proxies residenciales, móviles y de centros de datos de origen ético, creados para el scraping a escala. Pruébalos con el código promocional DICLOAK10 para obtener un descuento exclusivo.

- Huella digital del navegador: Los navegadores antidetección como DICloak son esenciales para evadir la detección basada en huellas dactilares, lo que le permite emular a usuarios reales y únicos con precisión.

- Comportamiento del usuario: Combine su configuración anti-detección con marcos de automatización (por ejemplo, Puppeteer, Selenium) mejorados por acciones similares a las humanas: retrasos aleatorios, desplazamiento y patrones de navegación.

Juntos, estos componentes forman una base confiable para el raspado web escalable y de bajo riesgo, lo que permite a los equipos extraer datos críticos sin ser bloqueados.

Herramientas gratuitas

Complemento de cookies

Generador UA

Generador de direcciones MAC

Generador de IP

Lista de direcciones IP

Generador de código 2FA

Reloj Mundial

Cheque Anónimo

Verificador de Proxy

Verificador de anuncios de Facebook

Raspado web con IA

Herramientas SMM Gratis

Verificador de Sombreado de Twitter