O web scraping tornou-se uma ferramenta vital em todos os setores, impulsionando a análise competitiva, a pesquisa de mercado, o rastreamento de preços e muito mais. Mas, à medida que a raspagem se torna mais generalizada, o mesmo acontece com as contramedidas destinadas a bloqueá-la. Os sites estão cada vez mais equipados com sistemas anti-bot que monitoram o tráfego de entrada e filtram qualquer coisa que pareça automatizada ou suspeita.

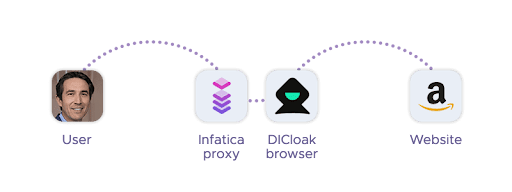

Isso cria um desafio crescente para os profissionais de dados: como extrair informações de forma confiável sem ser detetado ou bloqueado? Neste artigo, exploraremos como navegadores antidetecção como o DICloak desempenham um papel fundamental nessa estratégia, como eles se integram a soluções de proxy como as oferecidas pela Infatica e quais práticas recomendadas ajudam a manter suas operações em conformidade e eficazes.

As defesas anti-bot estão evoluindo

O web scraping tornou-se uma parte crítica das operações digitais – da agregação de preços à inteligência de mercado – mas à medida que as técnicas de scraping melhoram, o mesmo acontece com as defesas projetadas para detê-las. Os sites modernos implantam um arsenal crescente de mecanismos anti-bot que podem facilmente detetar e bloquear ferramentas tradicionais de scraping.

Essas defesas vão muito além do limite básico da taxa de IP. Sistemas sofisticados analisam as impressões digitais do navegador, monitoram padrões de movimento do mouse e rastreiam comportamentos de carregamento de recursos para identificar atividades automatizadas. Navegadores sem cabeça, mesmo aqueles baseados em mecanismos de usuário reais como o Chromium ou o Firefox, geralmente carregam sinais reveladores de automação – como plugins ausentes, tamanhos de janela incomuns ou cadeias de caracteres previsíveis do agente do usuário.

A impressão digital desempenha um papel particularmente crucial: os sites podem coletar dezenas de pontos de dados (por exemplo, renderização de tela, WebGL, fuso horário, idioma, detalhes do sistema operacional) para criar uma assinatura de navegador exclusiva. Quando essa assinatura se repete em várias solicitações, levanta suspeitas – e geralmente resulta em um bloqueio.

Neste ambiente, as ferramentas tradicionais de raspagem ficam aquém. Evitar a deteção requer não apenas endereços IP rotativos, mas também identidades rotativas – até o nível de características de hardware e software. Não é mais suficiente apenas enviar solicitações HTTP ou usar um navegador sem cabeça; A raspagem bem-sucedida requer uma estratégia de pilha completa que reduz sua visibilidade como bot.

O papel dos navegadores anti-detectar no Web Scraping

É aí que navegadores anti-detecção como o DICloak entram em cena: eles são capazes de imitar usuários genuínos em todas as camadas de interação. Isso inclui o uso de endereços IP limpos e rotativos, impressões digitais realistas do navegador e padrões de comportamento semelhantes aos humanos.

Os navegadores anti-detecção são ferramentas criadas especificamente para ajudar os utilizadores a aparecer como visitantes genuínos e únicos quando acedem a websites. Para profissionais de web scraping, eles servem como uma alternativa poderosa às ferramentas de automação tradicionais, oferecendo controle granular sobre impressões digitais do navegador, parâmetros de rede e sinais comportamentais.

Ao contrário dos navegadores sem cabeça padrão, que geralmente usam configurações padrão ou em branco, os navegadores antidetecção permitem que os usuários manipulem e aleatorizem uma ampla gama de atributos. Isso inclui a cadeia de caracteres do agente do usuário, a resolução da tela, as fontes do sistema, o fuso horário, os detalhes da CPU e da GPU e até mesmo dados de impressão digital WebGL ou tela. Ao fazer isso, criam perfis de navegador convincentes e não repetitivos que espelham usuários reais com alta fidelidade.

Muitos navegadores antidetecção também suportam perfis persistentes e armazenamento de sessão, tornando-os ideais para tarefas de scraping que exigem credenciais de login, gerenciamento de cookies ou navegação em várias etapas. Combinados com ferramentas de automação como Puppeteer ou Selenium (via plugins ou APIs), os navegadores anti-detecção permitem a raspagem escalável e furtiva em níveis de pequenas e empresas.

Combinando navegadores anti-detecção com proxies

Mesmo a impressão digital do navegador mais sofisticada não pode ignorar os sistemas anti-bot sozinha – sem a infraestrutura de rede certa, as tentativas de raspagem ainda levantarão sinais de alerta. É por isso que emparelhar como DICloak com proxies de alta qualidade é essencial para qualquer operação séria de web scraping. Mas o que são proxies?

Os proxies servem como a primeira linha de defesa, roteando o tráfego através de endereços IP alternativos, ajudando a evitar limites de taxa e proibições de IP. No entanto, nem todos os proxies são criados da mesma forma: os sites muitas vezes podem detetar e bloquear proxies de baixa qualidade ou mal configurados, especialmente aqueles com padrões suspeitos ou reputações de IP compartilhadas.

Quando usados em conjunto, proxies e navegadores anti-detecção formam uma dupla furtiva e adaptável. Enquanto o navegador antidetecção lida com a impressão digital do lado do navegador – simulando o comportamento real do usuário – o proxy lida com a identidade do lado da rede, permitindo que os usuários pareçam estar se conectando de diferentes países, regiões ou até mesmo redes móveis.

Essa combinação é particularmente poderosa para casos de uso, como raspagem localizada, criação de conta ou acesso a conteúdo com restrição geográfica. Por exemplo, proxies residenciais rotativos podem ser combinados com perfis de navegador exclusivos para simular milhares de usuários genuínos de diferentes residências.

Na Infatica, oferecemos um conjunto completo de soluções de proxy – incluindo proxies residenciais, de datacenter e móveis – que se integram perfeitamente com navegadores anti-detecção. Projetados para desempenho e estabilidade, nossos proxies ajudam os profissionais de raspagem a evitar bloqueios, reduzir o tempo de inatividade e garantir acesso confiável aos dados em escala.

Aplicações do mundo real

A combinação de navegadores anti-detecção e proxies de alta qualidade desbloqueia uma ampla gama de poderosos casos de uso de web scraping em todos os setores. Vamos dar uma olhada mais de perto em cenários comuns do mundo real onde esse emparelhamento de tecnologia se mostra inestimável:

Monitoramento de preços entre regiões

Empresas de comércio eletrônico e analistas confiam em navegadores antidetecção para extrair preços de mercados on-line sem desencadear restrições geográficas ou proibições de IP. Ao emparelhar proxies rotativos com perfis de navegador exclusivos, os scrapers podem simular usuários locais em vários países e comparar preços ou descontos regionais.

Agregação de viagens e inteligência tarifária

As plataformas de reserva de voos e hotéis geralmente oferecem conteúdo diferente, dependendo da localização do usuário e da configuração do navegador. Usando um navegador anti-detecção, os raspadores podem variar as impressões digitais, enquanto os proxies simulam solicitações de diferentes cidades ou países, ajudando a coletar dados de viagem precisos e específicos do local.

Scraping SERP e Monitorização SEO

Os motores de busca personalizam os resultados com base na localização, no dispositivo e no comportamento anterior. Raspar SERPs sem deteção requer uma identidade de navegador convincente e roteamento de proxy confiável. Os navegadores antidetecção permitem que os scrapers emulem usuários de desktop ou móveis, enquanto os proxies desbloqueiam resultados locais de regiões globais.

Geração de leads e coleta de dados públicos

Os profissionais de marketing B2B usam o scraping para reunir detalhes de contato, avaliações e listagens de plataformas como diretórios ou quadros de empregos. As configurações antidetecção permitem sessões persistentes e autenticadas – mesmo em sites fechados por login – enquanto os proxies garantem que as solicitações não sejam originadas do mesmo IP.

Verificação de anúncios e deteção de fraudes

Marcas e empresas de tecnologia de anúncios usam o scraping para verificar se os anúncios aparecem corretamente em geos e dispositivos. A combinação de perfis antidetecção com proxies específicos de localização permite uma visualização realista de como os usuários experimentam as campanhas e ajuda a detetar redirecionamentos ocultos ou fraudes de cliques.

Uma abordagem unificada para a raspagem furtiva

Os sistemas anti-bot modernos não dependem de um único sinal – eles analisam tudo, desde o seu endereço IP até a impressão digital do seu navegador e o comportamento do usuário. Para contornar essas defesas de forma confiável, as operações de raspagem devem aplicar furtividade em todos os níveis:

- Identidade da rede: Use proxies rotativos e de alta qualidade para evitar a deteção e acessar dados com restrição geográfica. A Infatica fornece proxies residenciais, móveis e de datacenter de origem ética – criados para raspagem em escala. Experimente-os com o código promocional DICLOAK10 para um desconto exclusivo.

- Impressão digital do navegador: Navegadores anti-detecção como o DICloak são essenciais para evitar a deteção baseada em impressões digitais, permitindo que você emule usuários reais e únicos com precisão.

- Comportamento do usuário: Combine sua configuração antidetecção com estruturas de automação (por exemplo, Puppeteer, Selenium) aprimoradas por ações semelhantes às humanas – atrasos aleatórios, rolagem e padrões de navegação.

Juntos, esses componentes formam uma base confiável para a raspagem da Web escalável e de baixo risco – permitindo que as equipes extraiam dados críticos sem serem bloqueadas.

Ferramentas Gratuitas

Cookie Plugin

Gerador de UA

Gerador de Endereço MAC

Gerador de Endereço IP

Lista de Endereços IP

Gerador de Código 2FA

Relógio Mundial

Verificação de Anonimato

Verificador de Proxy

Verificador de Anúncios FB

Coleta Web com IA

Ferramentas SMM Grátis

Verificador de Shadowban do Twitter

Verificador de Nomes do Instagram