Descobrindo as melhores ferramentas de raspagem da Web para suas necessidades

Extrair informações valiosas da web não é mais um luxo, é uma necessidade. Seja você um afiliado, um operador de comércio eletrônico, um gerente de mídia social, um analista de dados ou um anunciante digital,raspagem da webé a chave para desbloquear insights cruciais. Mas com tantas ferramentas disponíveis, encontrar a certa pode ser difícil.

A ferramenta certa de raspagem da web pode otimizar seu fluxo de trabalho, automatizar tarefas tediosas e capacitá-lo a tomar decisões baseadas em dados. Imagine rastrear sem esforço os preços dos concorrentes, gerar leads em escala, monitorar o sentimento da mídia social e coletar dados de mercado. Ferramentas eficazes de raspagem da web fornecem soluções para tudo, desde a simples extração de dados até a complexa navegação no site e a transformação de dados.

A escolha da ferramenta ideal, no entanto, depende de vários fatores. Você é um novato em codificação ou um desenvolvedor experiente? Você prefere uma solução baseada em nuvem ou uma instalação local? Qual é o seu orçamento? Algumas ferramentas oferecem níveis gratuitos para raspagem básica, enquanto outras oferecem recursos premium a um preço. Considerações técnicas, comoRecursos de renderização JavaScripteGerenciamento de proxypara lidar com restrições de sites, também desempenham um papel vital.

Principais recursos a serem considerados

Esta lista revelará as 6 melhores ferramentas de web scraping de 2025, selecionadas para atender às diversas demandas de aquisição de dados. Exploraremos uma variedade de opções, desde ferramentas intuitivas de raspagem visual ideais para iniciantes até estruturas robustas e personalizáveis projetadas para usuários avançados.

- Facilidade de uso: quão intuitiva é a interface da ferramenta? Você pode começar rapidamente sem um amplo conhecimento de codificação?

- Recursos de extração de dados: A ferramenta pode lidar com vários formatos de dados (por exemplo, HTML, XML, JSON)? Ele pode raspar sites dinâmicos que usam JavaScript?

- Escalabilidade: a ferramenta pode lidar com projetos de raspagem em grande escala? Ele oferece recursos como gerenciamento de proxy e rotação de IP para evitar ser bloqueado por sites?

- Preço: A ferramenta cabe no seu orçamento? Existem avaliações gratuitas ou níveis gratuitos disponíveis?

- Suporte ao cliente: A ferramenta oferece suporte confiável ao cliente caso você encontre problemas?

Ao investigar os pontos fortes e fracos de cada ferramenta, comparar seus modelos de preços e destacar seus principais recursos, capacitaremos você a escolher a ferramenta de raspagem da web perfeita. Prepare-se para transformar sua estratégia de aquisição de dados e desbloquear o verdadeiro potencial da web.

1. Octoparse

Octoparse é nossa principal recomendação de raspagem da web. Ele combina poderosos recursos de extração de dados com uma interface incrivelmente amigável. Isso o torna perfeito para quem quer aproveitar o poder dos dados da web sem precisar escrever nenhum código. Esteja você em marketing de afiliados, comércio eletrônico, gerenciamento de mídia social, análise de dados ou publicidade digital, a Octoparse oferece uma solução robusta para automatizar suas necessidades de coleta de dados.

Imagine coletar sem esforço detalhes de produtos de centenas de sites concorrentes, atualizando automaticamente seus preços e ganhando uma vantagem competitiva. Pense em extrair leads de diretórios on-line sem problemas, sobrecarregando seu pipeline de vendas sem a tediosa entrada manual de dados. O Octoparse torna esses cenários possíveis, liberando você para se concentrar na estratégia e no crescimento.

Extração de dados sem esforço

A interface intuitiva de apontar e clicar do Octoparse simplifica todo o processo de raspagem. Basta selecionar os dados de que você precisa e a ferramenta lida com a codificação complexa em segundo plano. Ele navega habilmente em sites complexos, incluindo aqueles que usamAJAXeJavaScript, e até lida com sites protegidos por login com facilidade. Precisa de dados por trás de uma parede de login? Octoparse tem tudo o que você precisa.

A ferramenta oferece opções de extração locais e baseadas em nuvem. A extração na nuvem permiteRaspagem automatizada 24 horas por dia, 7 dias por semana, liberando seu computador e largura de banda. A extração local fornece maior controle sobre seus dados e o processo de raspagem. Extrações programadas em intervalos regulares mantêm seus dados atualizados e relevantes. Você pode exportar seus dados em vários formatos, incluindoDistinguir-se,CSVe bancos de dados, garantindo integração perfeita com seus fluxos de trabalho atuais.

Características e benefícios

- Interface visual de apontar e clicar:Não é necessária codificação.

- Extração baseada em nuvem:Raspagem automatizada o tempo todo.

- Lida com sites complexos:Incluindo sites protegidos por login.

- Extração de dados programada:Mantém seus dados atualizados.

- Opções de exportação:Para Excel, CSV e bancos de dados.

Prós e contras

Profissionais:

- Amigável para iniciantes:Não é necessária experiência em codificação.

- Poderoso:Lida com sites complexos e conteúdo dinâmico.

- Flexível:Oferece opções de extração local e em nuvem.

- De apoio:Fornece excelente suporte ao cliente.

Contras:

- Velocidade de extração da nuvem:Pode ser limitado nos planos gratuitos e de nível inferior.

- Recursos avançados:Requer uma assinatura paga.

- Configurações complexas:Pode ter uma curva de aprendizado.

Preços e requisitos técnicos

O Octoparse oferece um plano gratuito com recursos limitados e planos pagos com níveis variados de funcionalidade e capacidade. Visite o site deles para obter os preços mais atualizados. Tudo o que você precisa para começar é um computador com conexão à Internet. A extração local requer o download e a instalação do software Octoparse.

Dica de implementação

Comece com um projeto simples para aprender a interface.Documentação do Octoparsee tutoriais irão guiá-lo.

Por que escolher o Octoparse?

Octoparse se destaca por sua mistura de potência e simplicidade. Sua interface intuitiva, recursos robustos e forte suporte ao cliente o tornam uma excelente escolha para usuários novos e experientes. Ao simplificar a raspagem da web, o Octoparse capacita qualquer pessoa a desbloquear o potencial dos dados da web. VisitarOctoparsepara saber mais e começar sua jornada de raspagem da web.

2. Scrapy: sua potência de raspagem da Web com tecnologia Python

Scrapy não é apenas mais uma ferramenta de raspagem da web; é uma estrutura completa e de código aberto construída sobrePitão. Ele foi projetado para dar a você controle total sobre como você extrai dados da web. Seja você um afiliado que rastreia programas, uma empresa de comércio eletrônico verificando preços de concorrentes, um gerente de mídia social analisando tendências, um analista de dados coletando informações ou um anunciante digital otimizando campanhas, o Scrapy oferece a escalabilidade e a flexibilidade de que você precisa. Ao contrário de ferramentas mais simples, o Scrapy oferece uma solução robusta e eficiente, perfeitamente adequada para projetos de raspagem em grande escala.

Imagine extrair facilmente detalhes do produto de centenas de sites concorrentes. Imagine automatizar a coleta de sentimentos de mídia social ou criar um banco de dados de leads personalizado a partir de várias fontes online. Scrapy torna essas tarefas complexas uma realidade. Seu suporte integrado para lidar com solicitações, navegar em páginas da Web e extrair dados – combinado com seletores baseados em expressões XPath e CSS – permite identificar os dados exatos de que você precisa com precisão de laser.

Por que Scrapy se destaca

Scrapy vai além da raspagem básica. Ele fornece uma estrutura completa para a criação de rastreadores da Web robustos e escaláveis. Sua arquitetura flexível, usandomiddlewareecomponentes de tubulação, permite o processamento e armazenamento de dados personalizados. Isso significa que você pode não apenas extrair dados, mas também limpá-los, transformá-los e salvá-los em seu formato preferido, prontos para análise ou integração com outros sistemas.

Características e benefícios

- Código aberto e gratuito:O uso do Scrapy é totalmente gratuito.

- Alimentado por Python:Aproveite o poder e a versatilidade do Python para todas as suas necessidades de extração de dados.

- Seletores integrados:Direcione facilmente dados específicos usando XPath e CSS.

- Arquitetura extensível:Personalize o tratamento de dados com middleware e pipelines.

- Rede assíncrona:O Scrapy lida com várias solicitações simultaneamente, aumentando drasticamente o desempenho.

- Manuseio robusto:Gerencia sem esforço unicode, redirecionamentos, cookies e autenticação.

- Forte apoio da comunidade:Beneficie-se de uma extensa documentação e de uma comunidade útil.

Prós e contras

Vamos pesar as vantagens e desvantagens:

| Profissionais | Contras |

|---|

| Gratuito e de código aberto | Requer conhecimento de Python |

| Escalável e eficiente para grandes projetos | Curva de aprendizado mais íngreme para iniciantes |

| Comunidade e documentação fortes | Configuração inicial mais complexa |

Dicas de implementação

Embora o Scrapy exija conhecimento de Python, os benefícios superam em muito a curva de aprendizado inicial. Instale o Scrapy usando pip:pip instalar scrapy. A documentação oficial tem tutoriais e exemplos abrangentes para guiá-lo. UmAmbiente virtualé recomendado para gerenciar as dependências do seu projeto.

Introdução ao Scrapy

Visite o site do Scrapypara mergulhar mais fundo na estrutura e explorar seu potencial.

Scrapy é mais do que uma ferramenta; é um investimento em suas habilidades de aquisição de dados. O poder, a flexibilidade e a escalabilidade o tornam a melhor escolha para raspagem séria da web. Leve sua extração de dados para o próximo nível – escolha Scrapy.

3. ParseHub: conquiste sites complexos com a simplicidade de apontar e clicar

O ParseHub se destaca como a potência para enfrentar os intrincados desafios de web scraping. Enquanto outras ferramentas podem ter dificuldades com sites dinâmicos e JavaScript complexo, o ParseHub se destaca. Imagine extrair dados de aplicativos de página única (SPAs), sites carregados de AJAX ou até mesmo aqueles protegidos por cookies. O ParseHub lida com tudo isso com uma interface visual intuitiva e recursos robustos de aprendizado de máquina.

Isso oferece um potencial incrível para vários profissionais. Os profissionais de marketing de afiliados que gerenciam vários programas podem coletar facilmente detalhes do produto, atualizações de preços e insights de concorrentes de diversas redes de afiliados. As empresas de comércio eletrônico podem monitorar os preços dos concorrentes, rastrear o estoque e coletar análises de produtos de várias plataformas.

Os analistas de dados acharão o ParseHub indispensável para lidar com cenários complexos de extração de dados. Os anunciantes digitais podem monitorar o desempenho da campanha publicitária e coletar dados dos concorrentes. Até mesmo os gerentes de mídia social podem usá-lo para análise competitiva e rastreamento de tendências, coletando dados valiosos de mídia social.

Em vez de escrever código complicado, basta apontar e clicar nos dados de que você precisa. Os algoritmos de aprendizado de máquina do ParseHub interpretam a estrutura do site e extraem informações relevantes automaticamente. Precisa interagir com formulários, clicar em botões ou navegar pela paginação? O ParseHub lida com essas interações perfeitamente.

Principais recursos e benefícios

- Interface visual com aprendizado de máquina:Nenhuma codificação é necessária! Aponte e clique para selecionar seus dados. O aprendizado de máquina do ParseHub faz o resto.

- Lida com sites complexos:Extraia dados de SPAs, sites com uso intenso de JavaScript e sites usando AJAX e cookies.

- Raspagem interativa:Clique facilmente em botões, preencha formulários, role páginas e navegue pela paginação.

- Extração baseada em nuvem:Agende tarefas de raspagem para serem executadas automaticamente na nuvem.

- Acesso à API:Integre o ParseHub em seus fluxos de trabalho e ferramentas existentes.

Profissionais

- Conquista locais complexos:O ParseHub é bem-sucedido onde outros raspadores falham.

- Nenhuma codificação necessária:Adequado para usuários de qualquer nível de habilidade técnica.

- Nível gratuito generoso: 5 projetose200 páginaspor corrida sem nenhum custo.

- Excelente suporte ao cliente:Receba assistência oportuna quando necessário.

Contras

- Limitações de Desktop App:Atualmente disponível apenas para Windows e macOS.

- Uso intensivo de recursos:Projetos maiores podem exigir recursos significativos do sistema.

- Curva de aprendizado mais íngreme:Embora livre de código, dominar as funcionalidades avançadas pode exigir algum tempo dedicado.

Preços e requisitos técnicos

O ParseHub oferece um plano gratuito e vários planos pagos com recursos crescentes e capacidade de raspagem. Visite oSite do ParseHubpara obter detalhes de preços atualizados. É necessário um aplicativo de desktop do Windows ou macOS.

Dicas de implementação

Comece com um projeto menor para se familiarizar com a interface. Utilize o tutorial interativo e explore a documentação abrangente fornecida. Aproveite a extração baseada em nuvem para tarefas recorrentes.

O ParseHub é a solução perfeita para quem enfrenta projetos desafiadores de raspagem da web. Seu poder e flexibilidade o tornam uma ferramenta valiosa para analistas de dados, profissionais de marketing afiliados, profissionais de comércio eletrônico e qualquer pessoa que busque extrair dados de sites complexos sem escrever nenhum código.

4. Beautiful Soup

Beautiful Soup é uma poderosa biblioteca Python projetada para web scraping. Ele se destaca na extração de dados de HTML e XML, tornando-o indispensável para trabalhar com dados da web. Seja você um afiliado rastreando preços, um analista de dados coletando informações ou um anunciante digital avaliando o desempenho, a Beautiful Soup pode melhorar drasticamente seu fluxo de trabalho.

Sua força está na análise de HTML e XML em uma estrutura de árvore navegável. Isso permite que você direcione e extraia facilmente os dados precisos de que precisa usando a sintaxe Python direta. Ao contrário de estruturas complicadas, o foco do Beautiful Soup na análise o torna leve e fácil de integrar. Ele até lida commarcação malformadasem problemas, economizando tempo e dores de cabeça.

O Beautiful Soup se integra perfeitamente com outras bibliotecas Python, especialmente oBiblioteca de solicitaçõespara buscar páginas da web. Essa combinação fornece uma solução robusta para suas necessidades de raspagem da web. Você pode extrair detalhes do produto, preços da concorrência, tendências de mídia social e muito mais. Sua análise flexível, combinada com o poder de processamento de dados do Python (pense emPandas), desbloqueia análise e manipulação avançadas.

Características e benefícios

O Beautiful Soup oferece um conjunto atraente de recursos que o tornam uma escolha obrigatória para web scraping:

- Integração Python:Funciona perfeitamente dentro do ecossistema Python.

- Análise flexível:Lida com ambosHTML e XMLFacilmente.

- Sintaxe simples:Navegar e manipular documentos analisados é intuitivo e direto.

- Vários analisadores:Suporta uma variedade de analisadores, incluindo

html.parser,lxmlehtml5lib, dando-lhe flexibilidade e escolha. - Manipula marcação malformada:Analisa normalmente até mesmo o HTML mais mal estruturado, um problema comum na web.

Prós e contras: uma visão equilibrada

Como qualquer ferramenta, Beautiful Soup tem seus pontos fortes e fracos:

| Profissionais | Contras |

|---|

| Gratuito e de código aberto | Requer conhecimento de Python |

| Fácil de aprender | Não é uma estrutura completa (por exemplo, não tem manipulação de JavaScript comoRaspado) |

| Excelente documentação | Pode ser mais lento para documentos extremamente grandes |

| Leve | |

Você pode encontrar recursos adicionais em nosso Mapa do Site de Ferramentas Gratuitas.

A simplicidade, flexibilidade e poder de análise do Beautiful Soup o tornam uma ferramenta de raspagem da web de primeira linha. Sua facilidade de uso, juntamente com o vasto ecossistema do Python, permite que você extraia e analise dados da web de forma eficaz. Embora exija Python básico, a curva de aprendizado é gerenciável. Se você precisa de uma solução de raspagem da web robusta, fácil de usar e gratuita, o Beautiful Soup é uma ótima escolha. Faça o download hoje e desbloqueie o potencial dos dados da web (https://www.crummy.com/software/BeautifulSoup/).

5. Selenium

O Selenium se destaca como uma verdadeira potência para web scraping, especialmente ao lidar com sites complexos e dinâmicos que muitas vezes atrapalham outras ferramentas. Embora não seja apenas um raspador da web dedicado, seus sofisticados recursos de automação do navegador o tornam incrivelmente versátil e eficaz para extrair dados. Imagine precisar de detalhes do produto de um site de comércio eletrônico usando rolagem infinita eAJAXpara carregar conteúdo. Onde os raspadores tradicionais podem vacilar, o Selenium brilha, imitando a interação humana para descobrir todos os dados de que você precisa.

Para aqueles que gerenciam várias entidades on-line – profissionais de marketing afiliados fazendo malabarismos com programas, operadores de comércio eletrônico rastreando estoque, gerentes de mídia social analisando tendências e anunciantes digitais supervisionando várias contas – a capacidade do Selenium de automatizar tarefas cruciais é um divisor de águas. Imagine automatizar logins, navegar em páginas complexas e extrair dados valiosos, tudo sem levantar um dedo. Os analistas de dados também apreciarão a capacidade da Selenium de lidar com sites complexos e pesados em JavaScript, desbloqueando o acesso a fontes de dados críticas.

O poder do selênio em ação

O Selenium controla um navegador da web (Cromar,Raposa de fogo,Bordae mais) como um usuário humano. Ele clica em botões, preenche formulários, rola páginas e executa JavaScript, tornando-o ideal para sites com conteúdo dinâmico. Isso também o torna uma ferramenta poderosa para testes de sites, garantindo a funcionalidade em diferentes navegadores.

Características:

- Automação de navegador com suporte para todos os principais navegadores

- Interação com elementos da web (clicar, digitar, rolar)

- Execução e renderização completas de JavaScript

- Suporte para autenticação, cookies e sessões

- Disponível em várias linguagens de programação (PitãoJavaC#)

Pesando os prós e contras

Profissionais:

- Renderização JavaScript impecável:Raspa o conteúdo renderizado em JavaScript sem problemas.

- Raspagem e testes precisos:Simula o comportamento real do usuário.

- Compatibilidade incomparável:Funciona com praticamente qualquer site, independentemente de sua complexidade.

- Flexível e personalizável:Adapta-se às suas necessidades específicas.

Contras:

- Sobrecarga do navegador:Mais lento do que as ferramentas de raspagem dedicadas devido à sobrecarga de executar uma instância completa do navegador.

- Uso intensivo de recursos:Requer mais recursos do sistema.

- Conhecimento de programação necessário:Requer alguma proficiência em programação para ser usado de forma eficaz.

- Risco de detecção:Mais suscetível à detecção por sistemas anti-raspagem. Considere usar um serviço de servidor proxy para atenuar isso.

Local na rede Internet: https://www.selenium.dev/

Dicas de implementação para o sucesso

- Escolha o WebDriver certo:Selecione o WebDriver correto para o seu navegador (por exemplo, ChromeDriver para Chrome).

- Implemente esperas explícitas:Certifique-se de que os elementos estejam totalmente carregados antes de interagir com eles para evitar erros.

- Aproveite as ferramentas de desenvolvedor do navegador:Use as ferramentas de desenvolvedor do seu navegador para identificar seletores para direcionamento de dados preciso.

- Considere a navegação sem cabeça:Execute o Selenium no modo headless (sem uma janela visível do navegador) para aumentar a velocidade e reduzir o consumo de recursos.

O poder e a flexibilidade do Selenium exigem conhecimento de programação. No entanto, sua capacidade de raspar praticamente qualquer site e lidar com o conteúdo dinâmico mais complexo o torna uma ferramenta inestimável para aqueles que levam a sério a raspagem da web. Se você está enfrentando tarefas desafiadoras de extração de dados, o Selenium pode ser a solução que você está procurando.

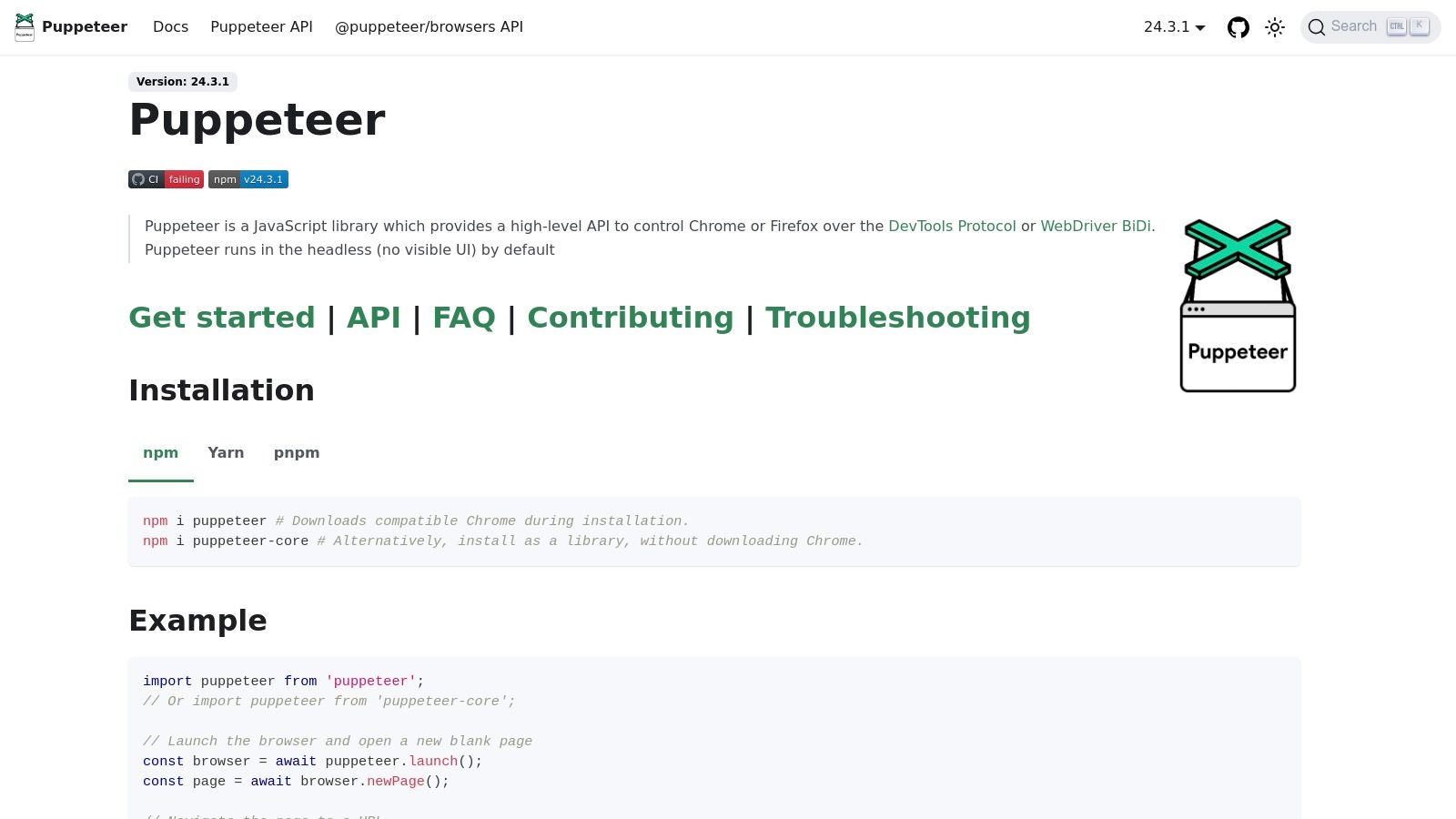

6. Puppeteer: sua ferramenta preferida para raspagem dinâmica da Web

Para aqueles que lidam com as complexidades de sites dinâmicos e pesados em JavaScript,Titereirosurge como a solução definitiva de raspagem da web. Profissionais de marketing afiliados, profissionais de comércio eletrônico, gerentes de mídia social, analistas de dados e anunciantes digitais, tomem nota: esta ferramenta é um divisor de águas. Ao contrário de ferramentas mais simples que muitas vezes falham com conteúdo dinâmico, o Puppeteer realmente se destaca. Desenvolvido porPesquise no GoogleesteNode.jsfornece controle total sobre um navegador Chrome ou Chromium sem cabeça, permitindo que você interaja com sites como um usuário real.

Imagine navegar perfeitamente em aplicativos de página única (SPAs), renderizar JavaScript e extrair exatamente os dados de que você precisa. Com o Puppeteer, isso se torna realidade. Seja rastreando preços de concorrentes, coletando insights de mídia social, monitorando o desempenho de anúncios ou compilando dados de produtos, a capacidade do Puppeteer de executar JavaScript desbloqueia um mundo de dados inacessível a outras ferramentas de raspagem.

Recursos de energia para raspagem poderosa

- Automação de navegador sem cabeça:Controle o Chrome ou o Chromium discretamente em segundo plano, maximizando a eficiência.

- Suporte completo a JavaScript:Renderize conteúdo dinâmico e interaja com sites sem problemas, imitando o comportamento real do usuário.

- API de alto nível:Automatize ações do navegador, como navegação, cliques e envios de formulários com facilidade.

- Geração de PDF e Captura de Tela:Capture capturas de tela de página inteira ou gere PDFs para uma análise off-line abrangente.

- Emulação móvel:Teste a capacidade de resposta do site e colete dados da perspectiva de um usuário móvel.

- Rastreamento de desempenho:Monitore o desempenho do site e identifique possíveis gargalos.

Por que o Puppeteer se destaca

A verdadeira força do Puppeteer está em sua capacidade de vencer os desafios de raspagem mais exigentes. Sua estreita integração com o Chrome DevTools Protocol fornece funcionalidade avançada, tornando-o a escolha perfeita para profissionais que exigem extração de dados robusta e confiável. Enquanto outras ferramentas podem oferecer soluções mais simples para sites estáticos, o Puppeteer brilha quando confrontado com conteúdo dinâmico, SPAs e interações complexas, consolidando sua posição como uma ferramenta essencial para web scrapers sérios.

Prós e contras do titereiro

Profissionais:

- Destaca-se com sites e SPAs com uso intenso de JavaScript:Ignore as limitações das ferramentas tradicionais de raspagem.

- Rápido e confiável:Apoiado pelo Google, garantindo estabilidade e desempenho consistentes.

- Forte suporte a TypeScript e documentação abrangente:Beneficie-se de uma digitação robusta e diretrizes claras para um desenvolvimento mais suave.

- Integração com o Chrome DevTools:Aproveite a funcionalidade avançada do navegador para controle granular.

Contras:

- Requer conhecimento de JavaScript/Node.js:Uma compreensão básica de JavaScript é essencial.

- Uso intensivo de recursos:Comparado a bibliotecas mais simples, o Puppeteer consome mais recursos.

- Compatibilidade limitada do navegador:O Puppeteer é compatível exclusivamente com Chrome/Chromium.

- Detectabilidade:Sistemas avançados anti-scraping podem detectar o Puppeteer. A implementação cuidadosa é fundamental para evitar a detecção.

Dicas de implementação

- Instalação:Instale o Puppeteer usando o npm:

npm instalar titereiro. - Operações assíncronas:Utilize async/await para execução e eficiência ideais do código.

- Técnicas anti-detecção:Empregue estratégias como rotação de proxy, randomização de agente de usuário e adesão às regras de robots.txt do site.

Preços e requisitos técnicos

O Puppeteer é de código aberto e totalmenteLivre para usar. Os únicos pré-requisitos sãoNode.jse npm (Node Package Manager) instalado em seu sistema.

Local na rede Internet

https://pptr.dev/

O Puppeteer permite que você supere os obstáculos da raspagem da web moderna, desbloqueando dados valiosos e fornecendo uma vantagem competitiva em seu campo. Embora seja necessário algum conhecimento de JavaScript, o acesso a dados precisos e seu impacto potencial o tornam um investimento valioso para web scrapers sérios.

Comparação direta das 6 principais ferramentas de raspagem da Web

| Ferramenta | Características ★ principais | Facilidade de uso 🏆 | Proposta 💰 de valor | Público-alvo 👥 | Pontos ✨ únicos |

|---|

| Octoparse | Apontar e clicar visual; Extração local e em nuvem | Muito amigável para iniciantes | Raspagem poderosa sem codificação | Profissionais de marketing, analistas de dados | Lida com AJAX, logins com excelente suporte |

| Raspado | Código aberto; estrutura assíncrona; Arquitetura extensível | Requer codificação; curva de aprendizado mais íngreme | Altamente escalável e gratuito | Desenvolvedores, cientistas de dados | Personalização avançada de middleware e pipeline |

| ParseHub | Interface visual; Aprendizado de máquina para detecção de estrutura | Intuitivo, embora alguma curva de aprendizado | Excelente na raspagem de sites com uso intenso de JavaScript | Não codificadores, usuários avançados | Interage com formulários e paginação |

| BeautifulSoup | Análise de HTML/XML; Biblioteca leve | Fácil para usuários básicos do Python | Simples e bem documentado | Programadores Python | Lida normalmente com marcação malformada |

| Selenium | Automação de navegadores; Execução JS; recursos de interação | Flexível, mas com uso intensivo de recursos | Confiável para raspagem dinâmica de conteúdo | Testadores, desenvolvedores | Simula o comportamento real do usuário |

| Puppeteer | Automação do Chrome sem cabeça; API de alto nível | Rápido com suporte oficial | Ideal para sites com uso intenso de JavaScript | Node.js desenvolvedores | Integrado ao protocolo Chrome DevTools |

Eleve sua raspagem na Web com o DICloak

Os métodos tradicionais de raspagem da web geralmente enfrentam desafios como banimentos e detecção de contas.A DICloak Technology Limited oferece uma solução poderosa: um navegador antidetecção projetado para aprimorar suas operações de raspagem da web. Esta ferramenta inovadora permite:

- Gerencie várias contas sem problemas:Simplifique seus fluxos de trabalho e maximize seu potencial de coleta de dados.

- Configure proxies de forma flexível:Melhore seu anonimato e ignore as restrições geográficas.

- Colabore de forma eficiente com sua equipe:Compartilhe configurações e dados sem problemas.

- Crie impressões digitais exclusivas do navegador:Minimize o risco de detecção e banimento de contas.

- Automatize tarefas com modelos de RPA:Aumente a produtividade e economize tempo valioso.

Seja você um afiliado, operador de comércio eletrônico, gerente de mídia social, analista de dados ou anunciante digital,DICloakcapacita você aDesbloqueie um novo nível de segurança e eficiência online. Pare de se preocupar com banimentos de contas e comece a maximizar seu potencial de raspagem na web. Visite a DICloak Technology Limited hoje.

Ferramentas Gratuitas

Cookie Plugin

Gerador de UA

Gerador de Endereço MAC

Gerador de Endereço IP

Lista de Endereços IP

Gerador de Código 2FA

Relógio Mundial

Verificação de Anonimato

Verificador de Proxy

Verificador de Anúncios FB

Coleta Web com IA

Ferramentas SMM Grátis

Verificador de Shadowban do Twitter

Verificador de Nomes do Instagram