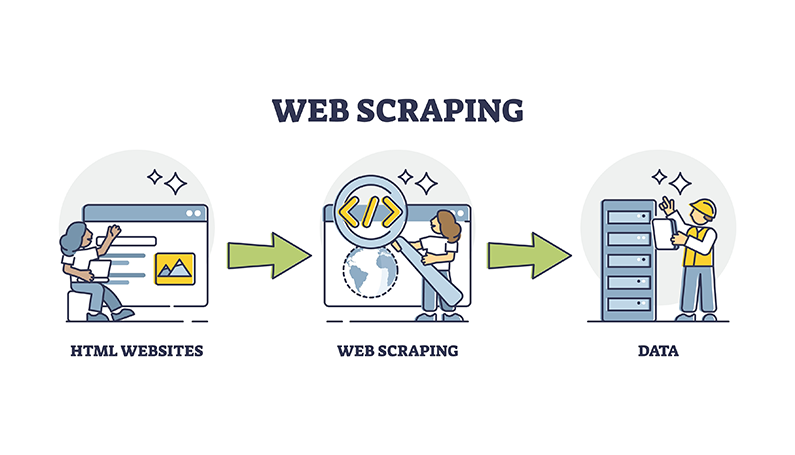

O que é web scraping?

Web scraping é o processo de extração automática de dados de sites usando programas de software ou bots. Envolve a busca de páginas da web e a análise do HTML ou de outros formatos de dados estruturados para extrair informações específicas.

Aqui estão os pontos-chave sobre web scraping:

Extração de dados:A raspagem da Web permite coletar grandes quantidades de dados de sites de forma automatizada, o que seria extremamente tedioso e demorado para fazer manualmente. Os dados extraídos podem estar na forma de texto, imagens, vídeos ou qualquer outro conteúdo presente nas páginas da web.

Processo automatizado:A raspagem da Web utiliza programas de software ou bots que podem navegar automaticamente por sites, buscar páginas da Web e extrair os dados desejados com base em padrões ou regras especificados. Essa automação permite a coleta de dados em uma escala muito maior e em um ritmo mais rápido em comparação com os esforços manuais.

Rastreamento da Web:Um componente crucial da raspagem da web é o rastreamento da web, que envolve a busca de páginas da web seguindo links e URLs. Os rastreadores da Web são usados para descobrir e baixar as páginas que precisam ser raspadas.

Análise e extração:Depois que as páginas da web são buscadas, o software de raspagem analisa o HTML ou outros formatos de dados estruturados para localizar e extrair os elementos de dados específicos de interesse. Isso pode ser feito usando técnicas como expressões regulares, XPath ou seletores CSS.

Formatação de dados:Os dados extraídos são normalmente limpos, estruturados e formatados em um formato mais utilizável, como CSV, JSON ou bancos de dados, para análise posterior ou integração em outros sistemas.

Por que ficar anônimo para raspagem da web?

Evite impressão digital e detecção do navegador:

Os sites geralmente empregam medidas anti-scraping, como detecção de bots e bloqueio de IP, para evitar a extração automatizada de dados. Ao usar o modo de navegação anônima, você pode ignorar alguns desses mecanismos de detecção, pois ele não armazena cookies, cache ou histórico de navegação que podem ser usados para impressão digital.

Resultados de pesquisa imparciais:

Sessões regulares de navegação podem levar a resultados de pesquisa personalizados com base em seu histórico de navegação e cookies. O modo de navegação anônima fornece uma lousa limpa, fornecendo resultados de pesquisa imparciais que não são influenciados por suas atividades online anteriores.

Sessões de navegação separadas:

O modo de navegação anônima permite que você mantenha sessões de navegação separadas, o que é útil ao extrair dados de vários sites ou contas simultaneamente. Essa separação evita a contaminação cruzada de cookies e dados armazenados em cache entre as sessões.

Visitas anônimas ao site:

Ao extrair conteúdo confidencial ou restrito, o modo de navegação anônima pode ajudar a mascarar sua identidade e padrões de navegação, pois não armazena nenhuma informação de identificação local, como histórico de navegação ou dados do site.

Evite interferência de cache e cookies:

As sessões regulares de navegação podem ser influenciadas por dados em cache e cookies existentes, o que pode afetar os dados raspados. O modo de navegação anônima fornece um novo ambiente livre de tais interferências, garantindo uma extração de dados mais precisa e consistente.

Desativando extensões:

O modo de navegação anônima desativa as extensões do navegador por padrão, o que pode ser benéfico durante a raspagem, pois algumas extensões podem interferir no processo de raspagem ou introduzir modificações indesejadas nos dados raspados.

No entanto, é importante observar que, embora o modo de navegação anônima ofereça alguns benefícios de privacidade, ele não fornece anonimato completo ou proteção contra técnicas avançadas de rastreamento empregadas por sites ou provedores de serviços de Internet (ISPs). Além disso, usar apenas o modo de navegação anônima pode não ser suficiente para operações de raspagem da Web em larga escala, onde ferramentas mais avançadas, como navegadores anti-detecção, proxies ou navegadores sem cabeça, podem ser necessárias para evitar medidas anti-scraping sofisticadas de forma eficaz.

As vantagens de usar navegadores antidetecção para web scraping

No campo da raspagem da web, os navegadores antidetecção oferecem inúmeras vantagens que aumentam a eficiência e o sucesso das atividades de coleta de dados. Esses navegadores são projetados especificamente para evitar mecanismos de detecção e manter o anonimato, tornando-os ferramentas inestimáveis para raspadores da web.

Mecanismos de detecção de desvio:

Os navegadores antidetecção ajudam a contornar as medidas anti-scraping implementadas por sites, como detecção de bots, bloqueio de IP e CAPTCHAs. Eles conseguem isso falsificando as impressões digitais do navegador, alternando os agentes do usuário e implementando atrasos entre as solicitações, fazendo com que as atividades de raspagem pareçam um comportamento humano.

Manter o anonimato online:

Os navegadores antidetecção protegem a privacidade online mascarando endereços IP reais, desativando scripts de rastreamento e ofuscando os detalhes do navegador. Esse anonimato é crucial para que os raspadores da web evitem ser rastreados ou bloqueados por sites.

Automatize tarefas de raspagem:

Os navegadores antidetecção são equipados com recursos de automação integrados que permitem automatizar tarefas de navegação e fluxos de trabalho de raspagem, melhorando a eficiência e reduzindo o esforço manual.

Coleta de dados de escala:

Os navegadores antidetecção permitem a criação de perfis de navegador virtual ilimitados com impressões digitais exclusivas, permitindo a coleta simultânea de dados de várias fontes enquanto aparecem como dispositivos separados. Essa escalabilidade é essencial para operações de raspagem da Web em larga escala.

Imite o comportamento humano:

Ao falsificar as impressões digitais do navegador e randomizar as características do navegador, como fusos horários e idiomas, os navegadores antidetecção podem imitar efetivamente usuários humanos reais, tornando mais difícil para os sites distinguir entre usuários legítimos e raspadores.

Integre com proxies:

Os navegadores antidetecção podem ser emparelhados com servidores proxy, aprimorando ainda mais o anonimato e os recursos de rotação de IP, que são cruciais para evitar mecanismos de detecção baseados em endereços IP.

Acesse conteúdo com restrição geográfica:

Com a capacidade de falsificar locais e endereços IP, os navegadores antidetecção permitem acessar sites e conteúdo com restrição geográfica, expandindo o escopo dos dados que podem ser coletados.

Embora os navegadores antidetecção sejam ferramentas poderosas para web scraping, é essencial usá-los de forma ética e legal, respeitando os termos de serviço do site e os regulamentos de privacidade de dados

Ferramentas Gratuitas

Cookie Plugin

Gerador de UA

Gerador de Endereço MAC

Gerador de Endereço IP

Lista de Endereços IP

Gerador de Código 2FA

Relógio Mundial

Verificação de Anonimato

Verificador de Proxy

Verificador de Anúncios FB

Coleta Web com IA

Ferramentas SMM Grátis

Verificador de Shadowban do Twitter

Verificador de Nomes do Instagram