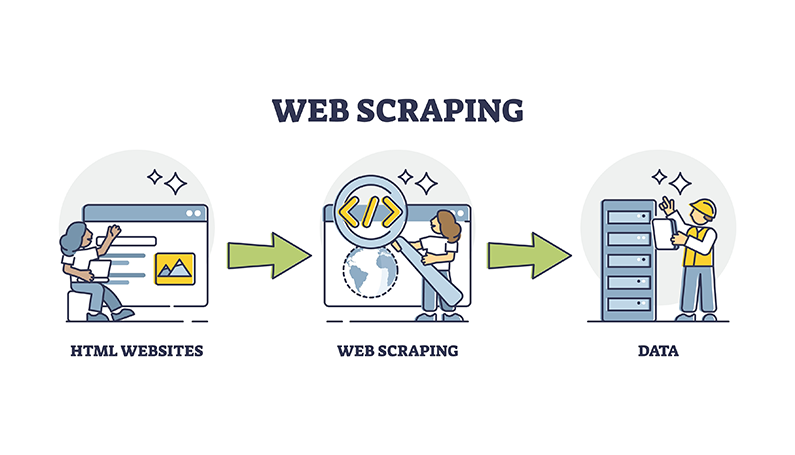

Qu’est-ce que le web scraping ?

Le web scraping est le processus d’extraction automatique de données de sites web à l’aide de logiciels ou de bots. Il s’agit d’extraire des pages Web et d’analyser le HTML ou d’autres formats de données structurées pour en extraire des informations spécifiques.

Voici les points clés concernant le web scraping :

Extraction des données : Le web scraping permet de collecter de grandes quantités de données à partir de sites web de manière automatisée, ce qui serait extrêmement fastidieux et chronophage à faire manuellement. Les données extraites peuvent prendre la forme de textes, d’images, de vidéos ou de tout autre contenu présent sur les pages Web.

Processus automatisé : Le grattage Web utilise des logiciels ou des robots qui peuvent naviguer automatiquement sur les sites Web, récupérer des pages Web et extraire les données souhaitées en fonction de modèles ou de règles spécifiés. Cette automatisation permet de récupérer les données à une échelle beaucoup plus grande et à un rythme plus rapide que les efforts manuels.

Exploration du Web : Un composant crucial du web scraping est le web crawling, qui consiste à récupérer des pages web en suivant des liens et des URL. Les robots d’indexation sont utilisés pour découvrir et télécharger les pages qui doivent être grattées.

Analyse et extraction : Une fois les pages Web récupérées, le logiciel de grattage analyse le HTML ou d’autres formats de données structurées pour localiser et extraire les éléments de données spécifiques qui vous intéressent. Cela peut être fait à l’aide de techniques telles que les expressions régulières, XPath ou les sélecteurs CSS.

Formatage des données : Les données extraites sont généralement nettoyées, structurées et formatées dans un format plus utilisable, tel que CSV, JSON ou bases de données, pour une analyse plus approfondie ou une intégration dans d’autres systèmes.

Pourquoi passer incognito pour le web scraping ?

Évitez la détection et l’empreinte digitale du navigateur :

Les sites Web utilisent souvent des mesures anti-grattage telles que la détection des bots et le blocage des IP pour empêcher l’extraction automatisée des données. En utilisant le mode incognito, vous pouvez contourner certains de ces mécanismes de détection car il ne stocke pas les cookies, le cache ou l’historique de navigation qui pourraient être utilisés pour l’empreinte digitale.

Résultats de recherche impartiaux :

Des sessions de navigation régulières peuvent conduire à des résultats de recherche personnalisés en fonction de votre historique de navigation et des cookies. Le mode Incognito fournit une ardoise vierge, fournissant des résultats de recherche impartiaux qui ne sont pas influencés par vos activités en ligne précédentes.

Sessions de navigation séparées :

Le mode Incognito vous permet de maintenir des sessions de navigation distinctes, ce qui est utile lors de l’extraction simultanée de données à partir de plusieurs sites Web ou comptes. Cette séparation empêche la contamination croisée des cookies et des données mises en cache entre les sessions.

Visites anonymes du site :

Lors de la récupération de contenu sensible ou restreint, le mode incognito peut aider à masquer votre identité et vos habitudes de navigation, car il ne stocke aucune information identifiable localement comme l’historique de navigation ou les données du site.

Évitez les interférences de cache et de cookies :

Les sessions de navigation régulières peuvent être influencées par les données mises en cache et les cookies existants, ce qui peut affecter les données récupérées. Le mode Incognito fournit un nouvel environnement exempt de telles interférences, assurant une extraction de données plus précise et plus cohérente.

Désactivation des extensions :

Le mode Incognito désactive les extensions de navigateur par défaut, ce qui peut être bénéfique lors du grattage, car certaines extensions peuvent interférer avec le processus de grattage ou introduire des modifications indésirables aux données grattées.

Cependant, il est important de noter que si le mode incognito offre certains avantages en matière de confidentialité, il n’offre pas un anonymat complet ou une protection contre les techniques de suivi avancées employées par les sites Web ou les fournisseurs d’accès à Internet (FAI). De plus, l’utilisation du mode incognito seul peut ne pas être suffisante pour les opérations de web scraping à grande échelle, où des outils plus avancés tels que des navigateurs anti-détection, des proxys ou des navigateurs sans tête peuvent être nécessaires pour échapper efficacement aux mesures anti-scraping sophistiquées.

Les avantages de l’utilisation de navigateurs anti-détection pour le web scraping

Dans le domaine du web scraping, les navigateurs anti-détection offrent de nombreux avantages qui améliorent l’efficacité et le succès des activités de collecte de données. Ces navigateurs sont spécialement conçus pour échapper aux mécanismes de détection et préserver l’anonymat, ce qui en fait des outils inestimables pour les grattoirs Web.

Mécanismes de détection de contournement :

Les navigateurs anti-détection permettent de contourner les mesures anti-grattage mises en œuvre par les sites Web, telles que la détection des bots, le blocage d’IP et les CAPTCHA. Ils y parviennent en usurpant les empreintes digitales du navigateur, en faisant tourner les agents utilisateurs et en mettant en œuvre des délais entre les demandes, ce qui fait apparaître les activités de grattage comme un comportement humain.

Préserver l’anonymat en ligne :

Les navigateurs anti-détection protègent la confidentialité en ligne en masquant les adresses IP réelles, en désactivant les scripts de suivi et en obscurcissant les détails du navigateur. Cet anonymat est crucial pour les web scrapers afin d’éviter d’être suivis ou bloqués par les sites web.

Automatisez les tâches de grattage :

Les navigateurs anti-détection sont équipés de fonctions d’automatisation intégrées qui permettent d’automatiser les tâches de navigation et de scraping des flux de travail, améliorant ainsi l’efficacité et réduisant les efforts manuels.

Collecte de données à l’échelle :

Les navigateurs anti-détection permettent de créer un nombre illimité de profils de navigateur virtuels avec des empreintes digitales uniques, ce qui permet la collecte simultanée de données à partir de plusieurs sources tout en apparaissant comme des appareils distincts. Cette évolutivité est essentielle pour les opérations de web scraping à grande échelle.

Imiter un comportement humain :

En usurpant les empreintes digitales du navigateur et en randomisant les caractéristiques du navigateur telles que les fuseaux horaires et les langues, les navigateurs anti-détection peuvent imiter efficacement les utilisateurs humains réels, ce qui rend plus difficile pour les sites Web de faire la distinction entre les utilisateurs légitimes et les scrapers.

Intégration avec les proxys :

Les navigateurs anti-détection peuvent être couplés à des serveurs proxy, ce qui améliore encore l’anonymat et les capacités de rotation des adresses IP, qui sont cruciales pour échapper aux mécanismes de détection basés sur les adresses IP.

Accéder au contenu géo-restreint :

Avec la possibilité d’usurper des emplacements et des adresses IP, les navigateurs anti-détection permettent d’accéder à des sites Web et à du contenu géo-restreints, élargissant ainsi la portée des données qui peuvent être extraites.

Bien que les navigateurs anti-détection soient des outils puissants pour le web scraping, il est essentiel de les utiliser de manière éthique et légale, en respectant les conditions d’utilisation des sites web et les réglementations sur la confidentialité des données

Outils gratuits

Extension de cookie

Générateur UA

Générateur d'adresse MAC

Générateur d'IP

Liste des adresses IP

Générateur de code 2FA

Horloge mondiale

Vérification Anonyme

Vérificateur de proxy

Vérificateur d'annonces FB

Extraction de données web par IA

Outils SMM gratuits

Vérificateur d'ombre bannissement Twitter