Web scraping é como ter um superpoder. Ele permite que você colete informações de sites automaticamente. Pense nisso como uma maneira super-rápida de copiar e colar, mas em uma escala enorme. Isso é ótimo para muitas coisas. Por exemplo, você pode acompanhar preços, verificar notícias ou coletar dados para o seu negócio. Mas às vezes, o web scraping pode ser complicado. Os sites podem tentar te impedir. Não se preocupe! Este guia mostrará as melhores ferramentas de web scraping. Também vamos te ensinar como usá-las. E até vamos compartilhar algumas dicas para te ajudar a obter os dados que você precisa.

O que é Web Scraping?

Antes de mergulharmos nas ferramentas, vamos entender rapidamente o que é web scraping. Imagine que você quer coletar todos os nomes e preços de produtos de uma loja online. Fazer isso manualmente levaria muito tempo. As ferramentas de web scraping fazem esse trabalho por você. Elas são programas que visitam sites, leem as informações e depois as salvam de uma maneira que você pode usar, como uma planilha. É uma maneira poderosa de transformar o conteúdo do site em dados úteis.

Principais Ferramentas de Web Scraping que Recomendamos

Escolher a ferramenta de scraping certa é importante. Existem muitas opções. Algumas são simples para iniciantes. Outras são robustas para especialistas. Aqui estão algumas das melhores ferramentas de scraping disponíveis hoje:

ScraperAPI: A Solução Tudo-em-Um

ScraperAPI é uma escolha muito popular. É ótima para desenvolvedores. Por quê? Porque ela cuida de muitas partes difíceis do web scraping para você. Os sites frequentemente tentam bloquear scrapers. Eles usam coisas como proxies, CAPTCHAs e banimentos de IP. ScraperAPI cuida de tudo isso. Você apenas envia um pedido simples, e ela te fornece os dados limpos. Isso economiza muito tempo e trabalho.

•Características: Ele gerencia proxies, resolve CAPTCHAs e tenta novamente solicitações que falharam. Ele pode contornar sistemas anti-bot difíceis como Cloudflare e DataDome. Também fornece dados de uma maneira limpa e estruturada.

•Como Usar: Você usa sua API. Isso significa que você envia um comando simples para o ScraperAPI, informando qual site você deseja extrair dados. Então, o ScraperAPI faz o trabalho duro e envia os dados de volta para você. É como pedir a um ajudante para obter informações para você.

•Melhor Para: Desenvolvedores e equipes que precisam extrair muitos dados de forma confiável. É bom para grandes projetos onde você não quer se preocupar em ser bloqueado.

ScrapingBee: Extração Inteligente e Fácil

ScrapingBee é outra excelente ferramenta de extração. Também é uma API, o que significa que funciona de maneira semelhante ao ScraperAPI. É conhecida por ser inteligente e fácil de usar. Pode lidar com sites que usam muito JavaScript, o que pode ser complicado para outras ferramentas.

•Características: Possui um recurso de extração alimentado por IA. Você pode dizer a ele o que extrair em inglês simples! Também suporta renderização de JavaScript, tira capturas de tela e oferece diferentes tipos de proxies. Ele fornece dados JSON limpos.

•Como Usar: Assim como o ScraperAPI, você envia uma solicitação para o ScrapingBee com a URL do site. Ele então gerencia o processo de scraping, incluindo rotação de proxies e contorno de medidas anti-bot. É projetado para ser simples para os desenvolvedores integrarem em seus projetos.

•Melhor Para: Desenvolvedores que desejam uma API poderosa, mas fácil de usar. É especialmente bom para sites com estruturas complexas ou fortes medidas anti-scraping.

Octoparse: Scraping Sem Código para Todos

Se você não sabe como programar, o Octoparse é uma ótima opção. É uma ferramenta de scraping sem código. Isso significa que você pode usá-la sem escrever nenhum código de computador. Você apenas clica nas partes do site que deseja extrair, e o Octoparse aprende o que fazer.

•Recursos: Possui uma interface visual. Você pode apontar e clicar para selecionar dados. Também tem scraping em nuvem, o que significa que pode executar suas tarefas de scraping em seus próprios servidores. Isso é bom para tarefas grandes.

•Como Usar: Você baixa o software do Octoparse. Em seguida, abre o site que deseja extrair dentro da ferramenta. Você clica nos campos de dados que precisa (como nomes de produtos, preços ou avaliações). O Octoparse cria um

fluxo de trabalho para você. Depois, você executa a tarefa, e ele coleta os dados.

•Melhor Para: Iniciantes, pequenas empresas ou qualquer pessoa que precise extrair dados sem escrever código. É amigável ao usuário e poderoso o suficiente para muitas tarefas.

ParseHub: Clique e Extraia com Facilidade

ParseHub é outra excelente ferramenta de scraping sem código. Funciona permitindo que você clique nos dados que deseja extrair. É muito visual e fácil de entender. O ParseHub pode lidar com sites complexos, incluindo aqueles com rolagem infinita ou pop-ups.

•Características: Possui uma interface gráfica. Você pode selecionar dados com cliques. Também suporta scraping baseado em nuvem e pode baixar imagens e arquivos. Pode lidar com conteúdo dinâmico e formulários.

•Como Usar: Semelhante ao Octoparse, você abre o site no ParseHub. Em seguida, você clica nos elementos que deseja extrair. O ParseHub cria um modelo. Você pode então executar a tarefa de scraping, e ele entregará os dados em formatos como CSV, JSON ou Excel.

•Melhor Para: Usuários que preferem uma abordagem visual para web scraping e precisam lidar com estruturas de sites mais complexas sem codificação.

Scrapy: Para os Desenvolvedores Python

Scrapy é um framework gratuito e de código aberto. É construído para desenvolvedores Python. Se você conhece Python, o Scrapy oferece muito controle. É muito poderoso para construir crawlers e scrapers web personalizados. Não é para iniciantes, mas é um favorito entre usuários experientes.

•Características: É altamente personalizável. Você pode construir lógicas de raspagem complexas. Ele lida com solicitações, respostas e processamento de dados. Também possui suporte embutido para gerenciar sessões e cookies.

•Como Usar: Você escreve código Python para definir como o Scrapy deve rastrear um site e extrair dados. É uma ferramenta de linha de comando, então você executa seus projetos de raspagem a partir do terminal do seu computador.

•Melhor Para: Desenvolvedores Python experientes que precisam construir soluções de raspagem web personalizadas e de alto desempenho para projetos em grande escala.

Bright Data: Uma Plataforma de Dados Abrangente

Bright Data é mais do que apenas uma ferramenta de raspagem; é uma plataforma completa de coleta de dados. Oferece uma ampla gama de redes de proxy (data center, residencial, ISP, móvel) e várias soluções de raspagem. É conhecida por sua confiabilidade e capacidade de lidar com tarefas de raspagem complexas em grande escala.

•Características: Rede de proxy extensa, desbloqueador de web (para contornar bloqueios), coletor de dados (modelos de raspagem pré-construídos) e um navegador de raspagem. Ele fornece altas taxas de sucesso mesmo em sites desafiadores.

•Como Usar: Bright Data oferece diferentes produtos. Você pode usar suas redes de proxy com seus próprios raspadores personalizados (como o Scrapy). Ou, você pode usar o Coletor de Dados deles, que possui uma interface visual para configurar trabalhos de raspagem sem codificação. Eles também têm um Desbloqueador de Web que lida automaticamente com CAPTCHAs e tentativas de novo.

•Melhor Para: Empresas e desenvolvedores que precisam de coleta de dados confiável em grande escala com recursos avançados de anti-bloqueio. É uma solução premium para necessidades sérias de scraping.

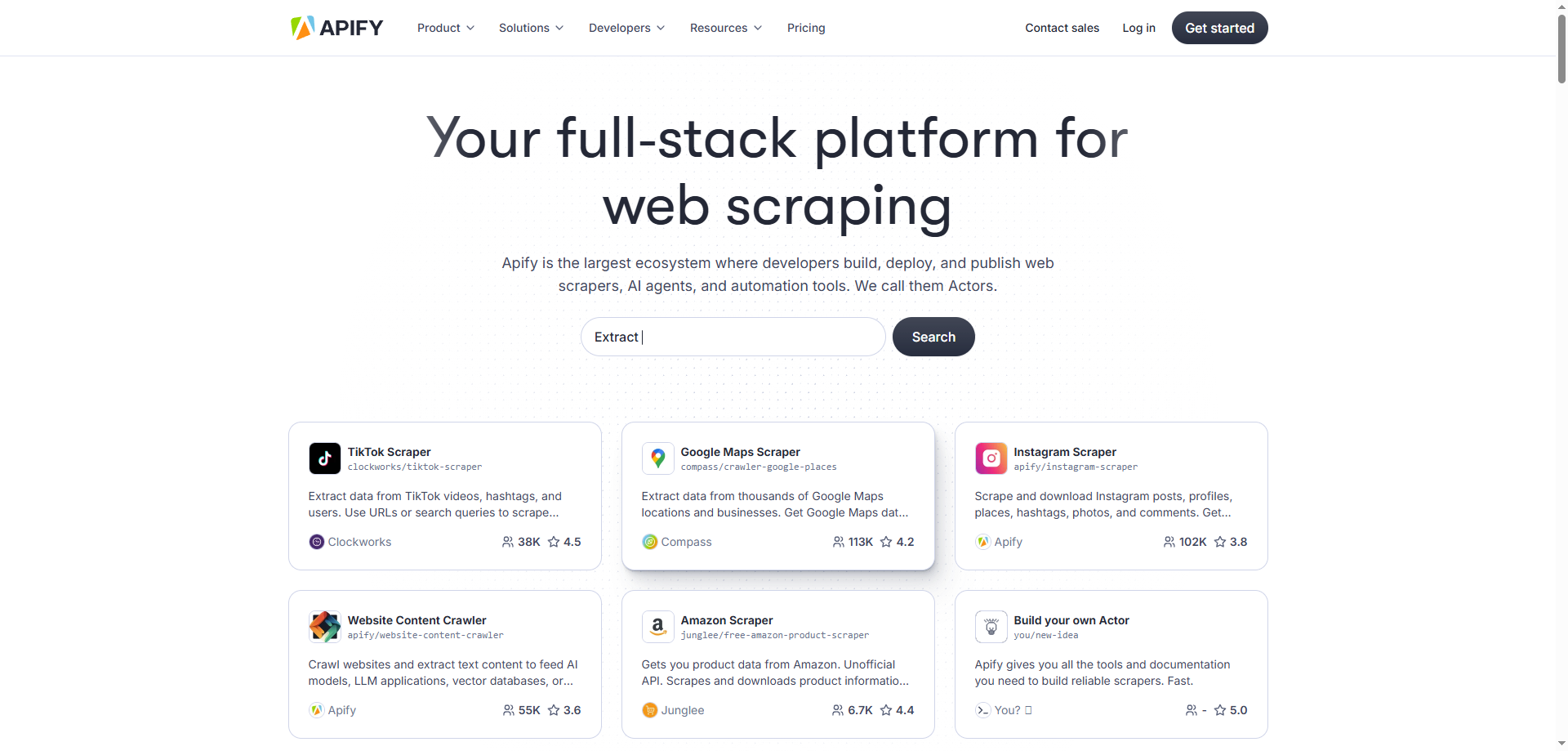

Apify: Construir e Executar Scrapers da Web

Apify é uma plataforma para construir, implantar e executar scrapers da web e tarefas de automação. Ela fornece um ambiente baseado em nuvem onde você pode desenvolver seus próprios scrapers usando JavaScript (Node.js) ou Python, ou usar soluções pré-construídas da sua Apify Store.

•Recursos: Plataforma em nuvem para executar scrapers, rotação de proxies, suporte a navegadores sem cabeça (Puppeteer, Playwright), agendador para tarefas recorrentes e integração com várias opções de armazenamento de dados. Também possui uma grande coleção de scrapers prontos para uso.

•Como Usar: Você pode escrever seu próprio código (Atores) na plataforma Apify ou usar os existentes. Por exemplo, você pode usar o seu

Web Scraper para scraping geral ou Atores específicos para plataformas como Instagram ou Google Maps. Apify cuida da infraestrutura, então você não precisa se preocupar com servidores ou escalabilidade.

•Melhor Para: Desenvolvedores e empresas que buscam uma plataforma flexível para construir e gerenciar soluções personalizadas de scraping da web e automação. É bom tanto para pequenos projetos quanto para operações em grande escala.

Selenium: Automação de Navegador para Scraping

O Selenium é principalmente uma ferramenta para automatizar navegadores da web. Embora seja frequentemente usado para testar sites, também é muito eficaz para web scraping, especialmente em sites dinâmicos que dependem fortemente de JavaScript. O Selenium controla um navegador real, portanto, pode interagir com páginas da web da mesma forma que um usuário humano faria.

•Características: Controla navegadores reais (Chrome, Firefox, etc.), lida com a execução de JavaScript, preenche formulários, clica em botões e navega por páginas. Suporta várias linguagens de programação.

•Como Usar: Você escreve código (por exemplo, em Python, Java, C#) para dizer ao Selenium o que fazer no navegador. Por exemplo, você pode instruí-lo a abrir uma URL, encontrar um elemento pelo seu ID, digitar texto em uma caixa de pesquisa e clicar em um botão. O Selenium então executa essas ações no navegador, e você pode extrair os dados da página carregada.

•Melhor Para: Web scraping de sites dinâmicos, aplicações de página única (SPAs) e sites que requerem interações complexas. Também é bom para fins de teste.

Beautiful Soup: Analisando HTML e XML

Beautiful Soup é uma biblioteca Python que é excelente para analisar documentos HTML e XML. Ela não busca páginas da web por conta própria; em vez disso, trabalha com o conteúdo HTML que você já baixou (por exemplo, usando a biblioteca requests em Python). Facilita a navegação, pesquisa e modificação da árvore de análise.

•Características: Fornece uma maneira simples de extrair dados de HTML. Lida com HTML malformado de forma elegante. Funciona bem com requests para buscar páginas.

•Como Usar: Primeiro, você usa uma biblioteca como requests para baixar o conteúdo HTML de uma página da web. Em seguida, você passa esse conteúdo HTML para o Beautiful Soup. Você pode então usar os métodos do Beautiful Soup para encontrar elementos específicos (como todos os links ou todos os parágrafos com uma certa classe) e extrair seu texto ou atributos.

•Melhor Para: Desenvolvedores Python que precisam analisar conteúdo HTML e extrair pontos de dados específicos. É frequentemente usado em combinação com outras bibliotecas para uma solução completa de scraping.

Puppeteer: Automação do Chrome Headless

Puppeteer é uma biblioteca Node.js que fornece uma API de alto nível para controlar o Chrome ou Chromium através do Protocolo DevTools. É frequentemente usado para navegação headless, o que significa executar o Chrome sem uma interface de usuário visível. Isso o torna muito rápido e eficiente para tarefas automatizadas como web scraping.

•Recursos: Controla o Chrome headless ou completo, gera capturas de tela e PDFs de páginas, automatiza o envio de formulários, testes de UI e pode rastrear aplicações de página única. É excelente para lidar com conteúdo renderizado em JavaScript.

•Como Usar: Você escreve código JavaScript para controlar o Chrome. Você pode dizer ao Puppeteer para navegar até uma página, esperar os elementos carregarem, interagir com eles (clicar, digitar) e então extrair dados. Como usa um motor de navegador real, pode lidar com páginas web complexas como um usuário humano.

•Melhor Para: desenvolvedores JavaScript que precisam extrair dados de sites dinâmicos, realizar automação de navegador ou gerar capturas de tela/PDFs. É uma ferramenta poderosa para os desafios modernos de web scraping.

Como Bypassar a Proteção do Cloudflare ao Fazer Scraping

Many websites use services like Cloudflare to protect themselves. Cloudflare acts like a shield. It stops bad bots and protects websites from attacks. But sometimes, it can also block legitimate web scrapers. Bypassing Cloudflare can be tricky, but it's possible. Here are some common ways:

1. Use um Navegador Sem Cabeça:

Cloudflare frequentemente verifica se você é um navegador real. Um navegador sem cabeça (como Puppeteer ou Playwright) é um navegador da web sem uma interface visual. Ele pode rodar em segundo plano. Essas ferramentas podem fazer com que seu scraper se comporte mais como um usuário real. Elas podem executar JavaScript e lidar com cookies, o que ajuda a contornar as verificações do Cloudflare.

2. Rotacionar Proxies:

Cloudflare pode bloquear seu endereço IP se você enviar muitas solicitações dele. Usar um pool de diferentes endereços IP (proxies) pode ajudar. Quando um IP é bloqueado, você muda para outro. Isso torna mais difícil para o Cloudflare detectar você como um bot.

3. Ajustar Cabeçalhos de Solicitação:

Quando seu navegador visita um site, ele envia informações chamadas

cabeçalhos. Esses cabeçalhos informam ao site sobre seu navegador, sistema operacional e outros detalhes. Se seu scraper não enviar cabeçalhos adequados, pode parecer suspeito. Certifique-se de que seu scraper envie cabeçalhos realistas, assim como um navegador da web normal faria. 4. Resolver CAPTCHAs: O Cloudflare às vezes exibe CAPTCHAs (aqueles quebra-cabeças que pedem para você clicar em todos os quadrados com semáforos). Algumas ferramentas e serviços de scraping, como ScraperAPI, têm resolução de CAPTCHA embutida. Você também pode usar serviços de resolução de CAPTCHA de terceiros. 5. Use uma API de Web Scraping Dedicada: Serviços como ScraperAPI e ScrapingBee são projetados para lidar com medidas anti-scraping, incluindo o Cloudflare. Eles têm técnicas avançadas e grandes pools de proxies para contornar essas proteções, facilitando muito sua vida.

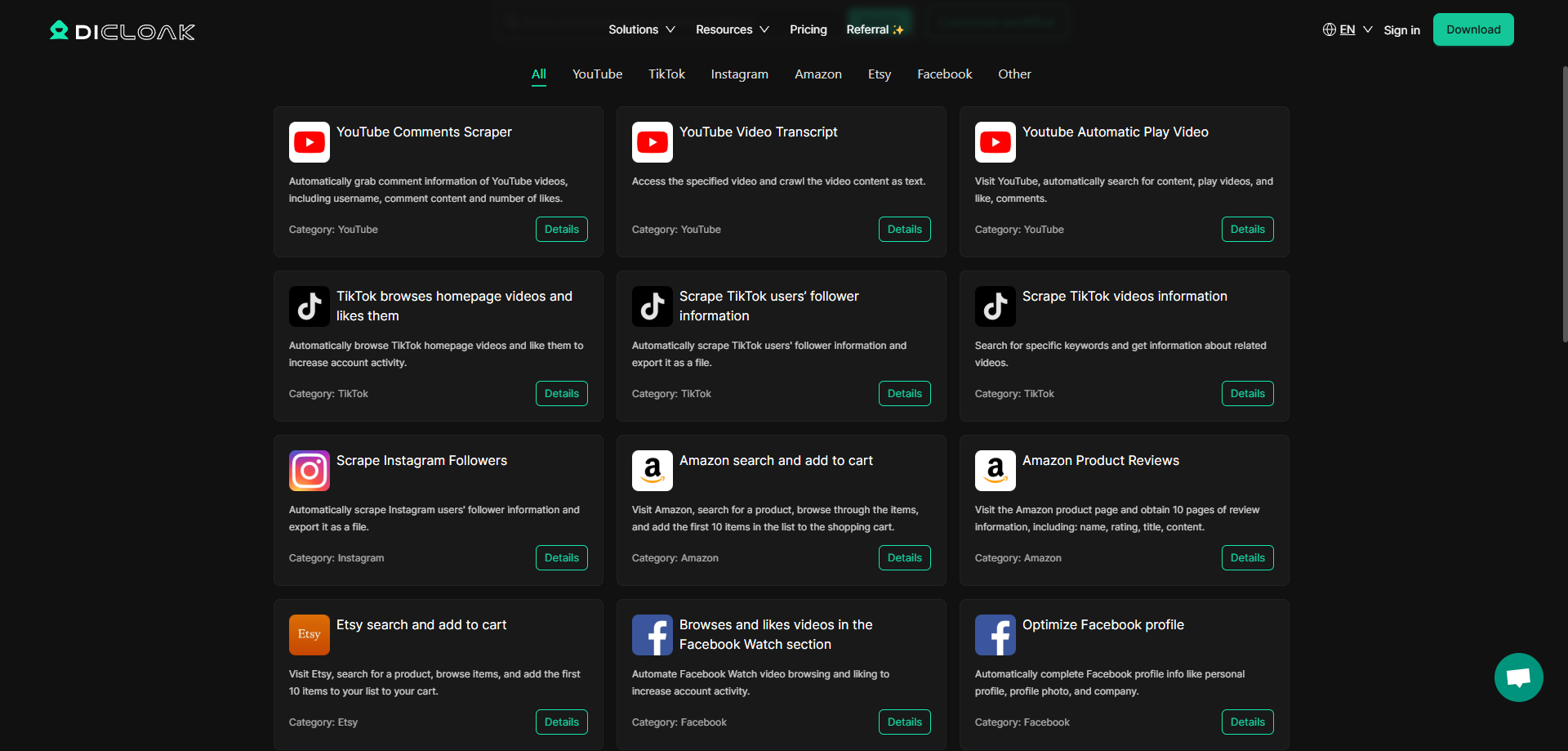

Embora as ferramentas acima sejam ótimas, às vezes você precisa de algo mais. Você pode precisar realizar tarefas complexas que envolvem mais do que apenas extração simples de dados. É aqui que uma ferramenta como o DICloak Antidetect Browser se torna útil. Não é apenas um navegador; é uma plataforma poderosa que pode ajudá-lo com coleta avançada de dados.

O navegador antidetect DICloak possui um recurso especial: RPA (Automação de Processos Robóticos). O que isso significa? Significa que você pode criar fluxos de trabalho automatizados personalizados. Imagine que você deseja extrair comentários de vídeos do YouTube. Ou talvez você precise interagir com um site de uma maneira muito específica, como preencher formulários ou clicar em botões em uma determinada ordem. O recurso RPA do DICloak permite que você configure essas tarefas complexas. Isso torna seus esforços de extração mais inteligentes e semelhantes ao comportamento humano, o que é ótimo para contornar defesas rigorosas de sites.

Essa capacidade de RPA é muito útil para tarefas que exigem muita interação. Ela pode imitar o comportamento humano, tornando sua extração menos detectável. Se você estiver interessado em configurar funções específicas de extração com RPA, como capturar comentários do YouTube ou outros dados detalhados, você pode entrar em contato com o serviço de atendimento ao cliente deles. Eles podem ajudá-lo a personalizar os recursos exatos de extração com RPA que você precisa.

Conclusão

A extração de dados da web é uma maneira poderosa de obter informações da internet. Seja você um iniciante ou um especialista, há uma ferramenta de extração para você. Desde opções fáceis de usar sem código, como Octoparse e ParseHub, até APIs poderosas como ScraperAPI e ScrapingBee, e até mesmo frameworks avançados como Scrapy, as escolhas são muitas. E para aquelas situações complicadas, ou quando você precisa de automação avançada, soluções como o navegador antidetect DICloak oferecem ainda mais possibilidades. Lembre-se de sempre extrair dados de forma responsável e respeitar os termos de serviço dos sites. Boa extração!

Ferramentas Gratuitas

Cookie Plugin

Gerador de UA

Gerador de Endereço MAC

Gerador de Endereço IP

Lista de Endereços IP

Gerador de Código 2FA

Relógio Mundial

Verificação de Anonimato

Verificador de Proxy

Verificador de Anúncios FB

Coleta Web com IA

Ferramentas SMM Grátis

Verificador de Shadowban do Twitter

Verificador de Nomes do Instagram