O Twitter, agora conhecido como X, é uma enorme fonte de informações em tempo real. Pessoas e empresas compartilham notícias, opiniões e tendências a cada segundo. Isso torna os dados do X muito valiosos por várias razões. Se você quer entender sobre o que as pessoas estão falando, acompanhar tendências de mercado ou até mesmo prever eventos futuros, um scraper do Twitter pode ajudá-lo a obter os dados de que precisa. Mas como isso funciona? E o que você pode fazer com esses dados? Vamos descobrir.

Por que coletar dados do Twitter (X)?

Existem muitas boas razões para usar um scraper do Twitter para coletar dados do X. Aqui estão algumas das principais:

•Entendendo Tendências: O X é onde novas tendências costumam começar. Ao coletar dados do X, você pode ver o que está se tornando popular. Isso ajuda as empresas a entender o que os clientes querem ou quais tópicos estão ganhando atenção.

•Pesquisa de Mercado: O que as pessoas pensam sobre um novo produto ou uma marca? Os dados do X podem te dizer. Você pode coletar tweets e analisá-los para ver a opinião pública. Isso é muito útil para pesquisa de mercado e desenvolvimento de produtos.

•Análise de Sentimento: Isso significa entender os sentimentos por trás dos tweets. As pessoas estão felizes, tristes ou irritadas com algo? Um scraper do Twitter pode ajudá-lo a coletar tweets para realizar a análise de sentimento. Isso pode ser usado para avaliar o humor público ou a reação a eventos.

•Análise Competitiva: Você pode acompanhar o que seus concorrentes estão fazendo no X. O que eles estão postando? Como as pessoas estão reagindo? Isso ajuda você a se manter à frente em sua indústria.

•Pesquisa Acadêmica: Pesquisadores costumam usar dados do X para estudar comportamento social, padrões de comunicação ou discurso público sobre vários tópicos. É uma rica fonte de interação humana no mundo real.

•Geração de Leads: Para empresas, o X pode ser um lugar para encontrar potenciais clientes. Você pode coletar menções de palavras-chave relacionadas ao seu negócio e encontrar pessoas que possam estar interessadas em seus produtos ou serviços.

Quais Dados Você Pode Extrair do Twitter (X)?

Um bom scraper de Twitter pode coletar muitos tipos de dados do X. Esses dados podem ser usados para diferentes propósitos. Aqui estão alguns tipos comuns de dados que você pode extrair:

•Tweets (Postagens): Este é o tipo mais básico de dado. Você pode extrair o texto dos tweets, juntamente com informações como quem postou, quando foi postado, quantos likes e retweets recebeu, e qualquer mídia anexada (imagens, vídeos, GIFs).

•Perfis de Usuário: Você pode obter detalhes sobre os usuários do X. Isso inclui o nome de usuário, nome exibido, contagem de seguidores, contagem de pessoas que está seguindo, biografia, localização e se a conta é verificada. Isso ajuda a entender quem está tweetando.

•Comentários (Respostas): Quando as pessoas respondem a tweets, essas respostas também são dados valiosos. Você pode extrair comentários para entender conversas e reações públicas a postagens específicas.

•Resultados de Pesquisa: Você pode extrair tweets com base em palavras-chave ou hashtags específicas. Isso é ótimo para acompanhar discussões sobre um tópico ou evento particular.

•Hashtags: Coletar todos os tweets que usam uma hashtag específica para analisar tendências e tópicos populares.

•Links de Mídia: Extrair links para imagens, vídeos e GIFs compartilhados em tweets. Isso é útil se você estiver fazendo análise de conteúdo.

•Listas de Seguidores e Seguindo: Você pode extrair listas de quem um usuário segue e quem os segue. Isso ajuda a mapear redes sociais e identificar usuários influentes.

É importante notar que, embora muitos dados públicos possam ser extraídos, alguns dados podem ser mais difíceis de obter sem fazer login ou usar técnicas avançadas. O X também tem regras sobre quais dados podem ser coletados e como podem ser usados.

Principais Ferramentas de Scraper do Twitter: Recursos, Uso e Preços

Escolher o scraper de Twitter certo depende das suas necessidades. Você é um desenvolvedor? Prefere uma solução sem código? Aqui estão algumas ferramentas populares:

Apify Scraper do Twitter (X): Baseado em Nuvem e Flexível

Apify é uma plataforma que permite construir e executar scrapers da web na nuvem. Eles oferecem um scraper dedicado para o Twitter (agora X Scraper) que pode extrair uma ampla gama de dados. É conhecido por sua flexibilidade e capacidade de lidar com tarefas de scraping em grande escala.

•Características: Extrai tweets, perfis de usuários, resultados de busca e mais. Ele lida com limites de taxa e fornece dados em formatos estruturados como JSON, CSV ou Excel. Você pode agendar tarefas de scraping e integrá-las com outras ferramentas. É uma solução baseada em nuvem, então você não precisa gerenciar servidores.

•Como Usar: Você pode usar o X Scraper pré-construído da Apify Store. Você simplesmente insere as URLs, nomes de usuários ou consultas de busca que deseja extrair. Você pode definir filtros e o número de resultados. Apify então executa o scraper para você, e você pode baixar os dados.

•Preços: Apify oferece um nível gratuito com uma certa quantidade de unidades de computação. Os planos pagos variam com base no uso (unidades de computação, armazenamento de dados, etc.). É uma solução escalável, o que significa que você paga pelo que usa.

•Melhor Para: Desenvolvedores e empresas que precisam de uma solução confiável, escalável e flexível baseada em nuvem para scraping de dados do X. É bom tanto para projetos pontuais quanto para coleta contínua de dados.

Octoparse Scraper do Twitter: Sem Código e Amigável ao Usuário

Octoparse é uma ferramenta popular de scraping da web sem código. Eles também oferecem um modelo específico de scraper para o Twitter. Isso significa que você não precisa escrever nenhum código para começar a extrair dados do X. É muito visual e fácil para iniciantes usarem.

•Recursos: Extrai tweets, perfis de usuários, comentários, curtidas, visualizações e mais. Possui uma interface de apontar e clicar. Suporta extração em nuvem, o que significa que suas tarefas de scraping são executadas nos servidores do Octoparse, liberando seu computador. Pode lidar com conteúdo dinâmico e rolagem infinita.

•Como Usar: Você baixa o software do Octoparse. Em seguida, pode usar o modelo de Scraper do Twitter pré-construído. Você insere as X URLs ou palavras-chave, e o Octoparse o orienta no processo de seleção dos dados que deseja. Uma vez configurado, você pode executar a tarefa e exportar os dados.

•Preços: O Octoparse oferece um plano gratuito com recursos limitados. Os planos pagos variam com base no número de crawlers, velocidade de extração em nuvem e outros recursos avançados. É uma boa opção para quem deseja evitar codificação.

•Melhor Para: Indivíduos e pequenas empresas que precisam extrair dados do X sem codificação. É ideal para pesquisa de mercado, geração de leads e monitoramento de redes sociais.

Bright Data Scraper do Twitter: Coleta de Dados de Nível Empresarial

Bright Data é uma plataforma líder em dados da web conhecida por suas extensas redes de proxy e soluções avançadas de scraping. Eles oferecem um scraper dedicado do Twitter que pode coletar uma ampla variedade de dados públicos do X com altas taxas de sucesso.

•Recursos: Coleta tweets, perfis de usuários, hashtags, links de mídia, threads de conversa, seguidores/seguindo e locais. Utiliza a robusta rede de proxy da Bright Data e a tecnologia de desbloqueio da web para contornar medidas anti-scraping. Garante entrega confiável de dados.

•Como Usar: Bright Data oferece várias maneiras de usar seu scraper. Você pode usar seu coletor de dados pré-construído, que é uma solução sem código. Ou, se você é um desenvolvedor, pode integrar sua API de scraping em seus scripts personalizados. Eles lidam com todas as complexidades técnicas de contornar bloqueios.

•Preços: A precificação da Bright Data é baseada no uso e pode variar dependendo do volume de dados e do tipo de serviços utilizados. Eles oferecem planos flexíveis adequados para coleta de dados em nível empresarial.

•Melhor Para: Empresas e desenvolvedores que precisam de dados X em grande escala, confiáveis e de alta qualidade para análises avançadas, inteligência de mercado ou monitoramento competitivo. É uma solução premium para necessidades de dados exigentes.

twscrape (Biblioteca Python): Para Desenvolvedores Python

twscrape é uma biblioteca Python de código aberto projetada para scraping de dados X (Twitter). É uma boa escolha para desenvolvedores que preferem escrever seus próprios scripts e ter controle total sobre o processo de scraping.

•Recursos: Permite o scraping de resultados de busca, perfis de usuários (seguidores/seguindo), tweets (favoritados/retweetados). Suporta autorização, o que pode ser útil para acessar certos tipos de dados.

•Como Usar: Você instala a biblioteca twscrape em seu ambiente Python. Em seguida, você escreve código Python para definir sua lógica de scraping. Você pode especificar quais dados coletar e como processá-los. É uma ferramenta de linha de comando, então você executa seus scripts a partir do seu terminal.

•Preços: Como uma biblioteca de código aberto, twscrape é gratuita para usar. No entanto, você precisará gerenciar sua própria infraestrutura, proxies e estratégias de anti-bloqueio.

•Melhor para: desenvolvedores Python que desejam construir raspadores personalizados do X. É adequado para aqueles com habilidades de programação que precisam de controle detalhado sobre suas operações de raspagem.

Playwright (com Python/Node.js): Automação de Navegador Sem Cabeça

Playwright é uma poderosa biblioteca de código aberto para automação de navegadores. Embora não seja um raspador dedicado do Twitter, pode ser usado para construir raspadores do X altamente eficazes, especialmente para conteúdo dinâmico. O Playwright controla um navegador da web real (sem cabeça ou visível), permitindo que interaja com o X como um usuário humano.

•Recursos: Automatiza Chrome, Firefox e WebKit. Pode lidar com renderização de JavaScript, clicar em elementos, preencher formulários e capturar solicitações de rede. Isso é crucial para raspar sites modernos como o X que carregam conteúdo dinamicamente.

•Como Usar: Você escreve código em Python ou Node.js para controlar o Playwright. Você instrui-o a navegar pelas páginas do X, esperar o conteúdo carregar, rolar e extrair dados. Ao capturar solicitações de rede em segundo plano, você pode frequentemente obter os dados brutos que o X usa para construir suas páginas, o que é mais limpo do que analisar HTML.

•Preços: O Playwright é gratuito e de código aberto. Você precisará gerenciar seus próprios recursos computacionais e medidas anti-bloqueio (como proxies).

•Melhor para: desenvolvedores que precisam raspar conteúdo dinâmico do X, realizar interações complexas ou contornar técnicas avançadas de anti-raspagem. Oferece um alto nível de controle e flexibilidade.

Legalidade e Considerações Éticas da Raspagem do Twitter (X)

Extrair dados do X, ou de qualquer site, vem com importantes considerações legais e éticas. Não se trata apenas do que você pode extrair, mas do que você deve extrair. Muitos artigos e discussões destacam as questões legais em torno da extração de dados da web, especialmente quando se trata de plataformas de mídia social.

•Termos de Serviço (ToS): A maioria dos sites, incluindo o X, possui Termos de Serviço que os usuários concordam. Esses termos frequentemente proíbem a extração automatizada de seu conteúdo. Violação dos ToS pode levar ao bloqueio do seu endereço IP, suspensão da sua conta ou até mesmo ações legais.

•Privacidade de Dados: Tenha muito cuidado com dados pessoais. Se você extrair informações pessoais (como nomes, endereços de e-mail ou localizações) de indivíduos, deve cumprir as leis de privacidade de dados, como o GDPR (Regulamento Geral sobre a Proteção de Dados) na Europa ou o CCPA (Lei de Privacidade do Consumidor da Califórnia) nos EUA. Essas leis protegem os direitos dos indivíduos em relação aos seus dados.

•Direitos Autorais: O conteúdo no X (tweets, imagens, vídeos) é frequentemente protegido por direitos autorais do criador original. Extrair e republicar esse conteúdo sem permissão pode levar a problemas de violação de direitos autorais.

•Dados Públicos vs. Privados: Geralmente, extrair dados disponíveis publicamente é menos arriscado do que extrair dados privados. No entanto, mesmo dados públicos podem ter restrições sobre seu uso. Sempre considere se os dados foram destinados a serem coletados em massa.

•Carga do Servidor: Extrair dados de forma muito agressiva pode colocar uma carga pesada nos servidores de um site, potencialmente interrompendo seu serviço. Isso é antiético e também pode levar ao bloqueio do seu IP.

Consulte sempre um advogado se você não tiver certeza sobre a legalidade de suas atividades de scraping, especialmente para fins comerciais. O importante é ser respeitoso, transparente e usar os dados de forma ética. Evite coletar dados privados, não sobrecarregue servidores e sempre verifique o arquivo robots.txt do site (que informa aos crawlers quais partes de um site eles podem ou não acessar).

Como Bypassar os Mecanismos Anti-Scraping do Twitter (X) e Evitar Banimentos

X, como muitas grandes plataformas, utiliza várias técnicas para prevenir scraping automatizado. Isso é chamado de mecanismos anti-scraping ou anti-bot. Se o seu scraper for detectado, seu endereço IP pode ser bloqueado ou suas solicitações podem ser limitadas (reduzidas). Aqui está como usar proxies e outros métodos para contornar isso e garantir que seu scraping não seja banido:

1. Use Proxies de Alta Qualidade:

• O que são: Proxies são servidores intermediários que ocultam seu verdadeiro endereço IP. Quando você usa um proxy, suas solicitações de scraping parecem vir do endereço IP do proxy, não do seu.

• Por que ajudam: X pode detectar se muitas solicitações vêm de um único endereço IP em um curto período de tempo. Ao rotacionar entre muitos endereços IP de proxy diferentes, você faz com que suas solicitações pareçam vir de muitos usuários diferentes, dificultando a detecção e o bloqueio por parte do X.

• Tipos: Proxies residenciais (IPs de usuários reais) são geralmente os melhores para contornar sistemas anti-bot rigorosos, pois parecem tráfego de usuários legítimos. Proxies de datacenter são mais baratos, mas mais facilmente detectados.

2. Rotacione User-Agents:

• O que são: Um User-Agent é uma string que seu navegador envia para um site, informando sobre o tipo do seu navegador, sistema operacional e versão. Os sites usam isso para servir o conteúdo corretamente.

•Por que eles ajudam: Se todas as suas solicitações usam o mesmo User-Agent, isso parece suspeito. Rotacione uma lista de User-Agents comuns e legítimos para fazer seu scraper parecer mais diversificado e humano.

3. Imitar Comportamento Humano:

•O que isso significa: Bots costumam se comportar de maneiras previsíveis (por exemplo, solicitações muito rápidas, sem movimentos de mouse, sem rolagem). Faça seu scraper agir mais como um humano.

•Como fazer isso: Introduza atrasos aleatórios entre as solicitações. Role para baixo nas páginas. Clique em elementos. Use navegadores sem interface (como Playwright ou Selenium) que podem executar JavaScript e renderizar páginas completamente, assim como um navegador real.

4. Lidar com CAPTCHAs e Limites de Taxa:

•CAPTCHAs: O X pode apresentar CAPTCHAs para verificar se você não é um bot. Algumas ferramentas ou serviços avançados de scraping oferecem capacidades de resolução de CAPTCHA (seja automatizadas ou por meio de serviços com suporte humano).

•Limites de Taxa: O X limita quantas solicitações você pode fazer em um determinado período. Respeite esses limites. Se você atingir um limite de taxa, pause seu scraper e tente novamente mais tarde. Scraping agressivo levará a banimentos.

5. Monitorar a Saúde do IP: Fique de olho nos seus IPs de proxy. Se um IP começar a ser bloqueado com frequência, remova-o do seu pool. Bons provedores de proxy costumam lidar com isso automaticamente.

6. Usar Gerenciamento de Sessão: Mantenha cookies e sessões. Isso faz com que seu scraper pareça ser um usuário recorrente, o que é menos suspeito do que uma nova solicitação para cada página.

Ao combinar essas estratégias, você pode aumentar significativamente sua taxa de sucesso e evitar ser banido enquanto faz scraping dos dados do X.

Para aqueles que precisam ir além da raspagem básica e enfrentar as medidas anti-bot mais desafiadoras, uma ferramenta especializada como o DICloak Antidetect Browser pode ser um divisor de águas. Não é apenas um navegador; é um ambiente poderoso projetado para raspagem da web eficiente e indetectável.

O DICloak Antidetect Browser ajuda você a criar perfis de navegador únicos. Cada perfil tem sua própria impressão digital (como versão do navegador, sistema operacional, plugins e mais). Isso faz com que cada uma de suas sessões de raspagem pareça um usuário real e diferente. Isso é muito eficaz contra sistemas avançados de anti-bot que analisam essas impressões digitais para detectar bots.

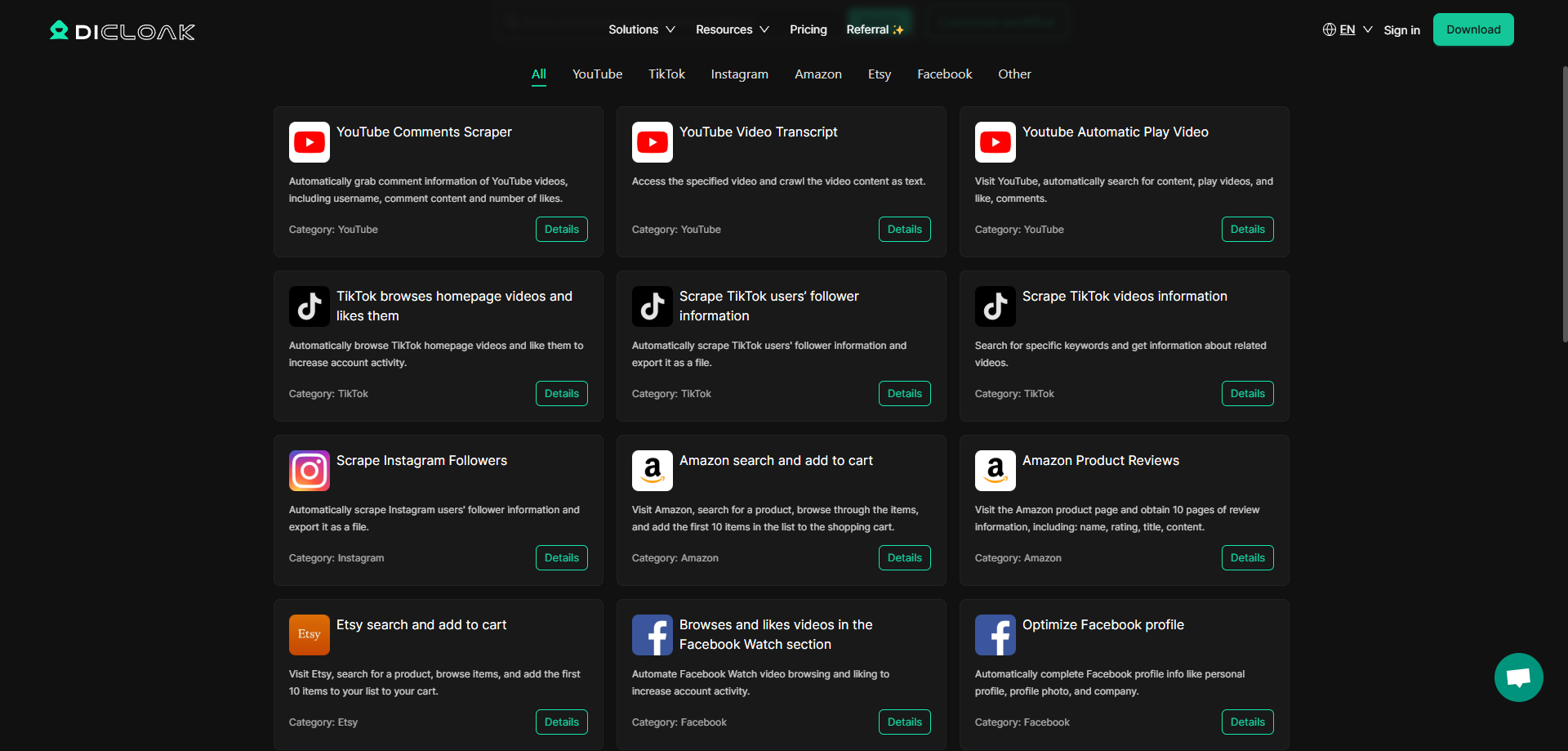

Mas o verdadeiro poder do DICloak Antidetect Browser reside em suas capacidades de RPA (Automação de Processos Robóticos). RPA permite que você automatize fluxos de trabalho complexos dentro do navegador. Imagine que você deseja raspar comentários do YouTube, mas precisa rolar para baixo várias vezes, clicar

nos botões 'Carregar mais' e lidar com pop-ups. O recurso de RPA do DICloak permite que você personalize essas ações complexas. Você pode gravar ações ou programá-las para imitar a interação humana perfeitamente. Isso torna seus esforços de raspagem muito mais robustos e menos propensos a serem detectados como automatizados.

Usar um Antidetect Browser para raspagem eficiente significa que você pode:

•Contornar Anti-Bots Avançados: As impressões digitais únicas do navegador ajudam você a passar por sistemas de detecção sofisticados.

•Automatizar Tarefas Complexas: RPA permite que você lide com processos de múltiplas etapas que raspadores comuns podem ter dificuldades.

•Manter Persistência de Sessão: Imitar o comportamento de usuário a longo prazo, o que é crucial para alguns cenários de raspagem.

•Escalar de Forma Eficaz: Executar múltiplos perfis de navegador isolados simultaneamente sem que eles interfiram uns com os outros.

Se você estiver interessado em configurar funções específicas de raspagem RPA, como capturar comentários do YouTube ou outros dados detalhados que exigem interações complexas, pode entrar em contato com o serviço de atendimento ao cliente da DICloak. Eles podem ajudá-lo a personalizar os recursos exatos de raspagem RPA que você precisa para tornar sua coleta de dados altamente eficiente e eficaz.

Conclusão

A raspagem de dados do Twitter (X) pode fornecer insights incrivelmente valiosos para empresas, pesquisadores e indivíduos. Desde entender o sentimento público até rastrear tendências de mercado, as informações disponíveis no X são vastas. Embora existam muitas ferramentas excelentes de raspagem do Twitter disponíveis, desde soluções sem código como Octoparse até poderosas bibliotecas Python como twscrape e frameworks de automação como Playwright, é crucial abordar a raspagem de forma responsável. Esteja sempre atento às considerações legais e éticas, respeite os termos de serviço e implemente estratégias para contornar mecanismos anti-raspagem.

Usando proxies de alta qualidade, rotacionando user-agents, imitando o comportamento humano e lidando com CAPTCHAs, você pode melhorar significativamente seu sucesso na raspagem. E para as tarefas mais desafiadoras, ou quando você precisa de automação avançada e discrição, ferramentas como o DICloak Antidetect Browser, com suas poderosas capacidades de RPA, oferecem uma solução de ponta para garantir que sua coleta de dados seja eficiente e indetectável. Boa raspagem, e lembre-se de sempre raspar de forma inteligente e ética!

Ferramentas Gratuitas

Cookie Plugin

Gerador de UA

Gerador de Endereço MAC

Gerador de Endereço IP

Lista de Endereços IP

Gerador de Código 2FA

Relógio Mundial

Verificação de Anonimato

Verificador de Proxy

Verificador de Anúncios FB

Coleta Web com IA

Ferramentas SMM Grátis

Verificador de Shadowban do Twitter

Verificador de Nomes do Instagram