La plupart des bases de données de prospects sont coûteuses et obsolètes. Beaucoup coûtent entre 3 000 et 20 000 $ par mois et vous donnent encore d’anciens contacts qui ne se convertissent plus. Dans des marchés en évolution rapide, ce type de données perd rapidement de la valeur.

Le scraping Linkedin offre une option plus intelligente. Cela vous permet de collecter des données publiques fraîches auprès des utilisateurs actifs de LinkedIn à un coût bien inférieur. Lorsqu’il est bien réalisé, le scraping Linkedin peut attirer de vrais prospects et même des e-mails vérifiés, pas seulement des liens de profil.

Le problème, c’est que la plupart des grattoirs Linkedin ne fonctionnent pas bien. Beaucoup sont bloqués, tombent en panne après les mises à jour ou exportent des données de faible qualité. Ce guide vous montre quels outils de scraping Linkedin fonctionnent réellement en 2026, comment les utiliser en toute sécurité et comment constituer votre propre base de données de prospects à jour sans gaspiller d’argent ni risquer vos comptes.

Qu’est-ce que le Linkedin Scraping ?

Le scraping LinkedIn consiste à utiliser des outils ou de l’automatisation pour collecter des données à partir de profils et pages LinkedIn au lieu de les copier à la main. Ces données incluent souvent des noms, des titres de poste, des entreprises, des lieux de vente et d’autres informations publiques. L’objectif du scraping Linkedin est de gagner du temps et de transformer les données de profil dispersées en une liste claire.

Par exemple, une équipe commerciale peut souhaiter une liste des responsables marketing à New York. Faire cela manuellement peut prendre des jours. Avec les outils de scraping Linkedin, ils peuvent analyser les profils publics en quelques minutes et exporter les données dans un tableur ou un CRM. Cela aide les équipes à se concentrer sur la sensibilisation plutôt que de cliquer sur les profils toute la journée.

Le scraping Linkedin est largement utilisé dans les ventes, le recrutement et les études de marché. Lorsqu’il est bien réalisé, il ne collecte que des informations publiques et respecte les paramètres de confidentialité ainsi que les lois locales. Utilisé de cette manière, le scraping Linkedin devient une méthode pratique pour recueillir des informations et soutenir efficacement la croissance de l’entreprise.

Tableau comparatif des outils de scraping Linkedin en 2026

| Outil |

idéal pour |

la force du tronc |

Scraping Profondeur |

d’automatisation Niveau |

de compétence |

| Skrapp |

Équipes commerciales |

Extraction vérifiée des emails professionnels |

Faible (axé sur le contact) |

Low |

Débutant |

| IA Octoparse |

Équipes d’opérations et de recherche |

Flux de travail RPA sans code |

Haut |

Très haut |

Intermédiaire |

| Evaboot |

Utilisateurs de Sales Navigator |

Exportations de plomb propre |

Douleur moyenne |

Low |

Débutant |

| PhantomBuster |

Équipes de croissance et marketing |

Flux de travail d’automatisation cloud |

Moyen-Haut |

Haut |

Intermédiaire |

| Assistant lié |

Recruteurs et commerciaux |

Scraping + sensibilisation en un seul outil |

Douleur moyenne |

Haut |

Intermédiaire |

| TexAu |

Agences et utilisateurs avancés |

Automatisation multiplateforme |

Moyen-Haut |

Très haut |

Avancé |

| Capitaine Data |

RevOps et équipes moyennes-grandes |

Flux de travail structurés et évolutifs |

Haut |

Haut |

Intermédiaire–Avancé |

| Waalaxy |

Freelances et petites équipes |

Prospection facile |

Low |

Douleur moyenne |

Débutant |

| Dux-soupe |

Équipes commerciales |

Campagnes de sensibilisation stable |

Douleur moyenne |

Douleur moyenne |

Débutant–Intermédiaire |

| Dripify |

Équipes commerciales et agences |

Sensibilisation cloud en permanence, |

Douleur moyenne |

Haut |

Débutant–Intermédiaire |

| Voici Alfred |

Équipes sortantes multi-canaux |

Boîte de réception unifiée |

Douleur moyenne |

Haut |

Intermédiaire |

| La Machine de Croissance |

Agences et spécialistes sortants |

Flux multi-canaux à haute réponse |

Douleur moyenne |

Haut |

Intermédiaire |

| Surfe |

Équipes commerciales pilotées par le CRM |

Enrichissement CRM en temps réel |

Bas-moyen |

Low |

Débutant |

| Bright Data |

Entreprises et développeurs |

Infrastructure de données à grande échelle |

Très haut |

Coutumes |

Avancé |

| ZenRows |

Startups & agences (API) |

Anti-bot scraping API |

Haut |

Coutumes |

Avancé |

| Derrick |

Équipes basées sur les feuilles |

Linkedin → Google Sheets |

Bas-moyen |

Low |

Débutant |

| Chien raclant |

Équipes données & analytique |

API de scraping Linkedin évolutive |

Très haut |

Coutumes |

Avancé |

Comment utiliser ce tableau (Guide pour lecteurs)

- Si votre objectif est la sensibilisation par email, commencez par Skrapp ou Evaboot

- Si vous avez besoin d’automatisation et de flux de travail répétables, regardez PhantomBuster, TexAu ou Captain Data

- Si vous dirigez des agences ou des équipes sortantes, La Growth Machine, Dripify et Meet Alfred conviennent mieux

- Si vous êtes développeur ou équipe de données, Bright Data, ZenRows ou Scrapingdog sont plus adaptés

- Si vous voulez quelque chose de simple et à faible risque, Waalaxy, Dux-Soup ou Derrick sont des points d’entrée plus faciles

Meilleurs outils de scraping Linkedin pour 2026 (critiques approfondies)

Skrapp est un outil de scraping Linkedin axé sur la découverte des emails professionnels. Il n’est pas conçu pour gratter chaque détail d’un profil. Au contraire, cela résout un problème clair : transformer les profils LinkedIn en données de contact utilisables pour les ventes sortantes.

Beaucoup d’équipes utilisent Skrapp après avoir déjà des prospects via LinkedIn ou Sales Navigator. L’outil aide ensuite à combler l’écart entre un profil et une boîte de réception.

Caractéristiques principales

- Extension Chrome qui fonctionne directement sur les pages LinkedIn et Sales Navigator

- Extraction massive des emails professionnels à partir de recherches de profil ou d’entreprise

- Vérification en temps réel par e-mail pour réduire le risque de rebond

- Recherche d’employés basée sur le domaine pour la prospection au niveau de l’entreprise

- Exportation CSV et accès API pour synchroniser avec les outils de vente

Avantages

- Installation très rapide avec presque aucune courbe d’apprentissage

- Les résultats par email sont généralement fiables pour les postes B2B

- Fonctionne sans accroc avec les flux de travail de Sales Navigator

Inconvénients

- Données de profil limitées au-delà des coordonnées

- La disponibilité des emails dépend fortement du secteur et de la taille de l’entreprise

Le meilleur pour Skrapp est idéal pour les équipes commerciales et les fondateurs qui utilisent déjà LinkedIn pour la prospection et souhaitent construire des listes d’emails sortantes sans acheter de bases de données tierces.

2. IA Octoparse

Octoparse AI est plus proche d’un logiciel RPA qu’un scraper classique. Il considère le scraping Linkedin comme une étape au sein d’un flux d’automatisation plus long, comme extraire → nettoyer → stocker → réutiliser.

Cela le rend puissant, mais aussi plus complexe que les outils plug-and-play.

Caractéristiques principales

- Créateur de flux de travail assisté par IA pour sites web dynamiques

- Interface sans code avec étapes visuelles

- Exécution sur le bureau avec contrôle du timing et des actions

- Exportation de données vers Excel, des bases de données ou des systèmes internes

Avantages

- Très flexible pour la logique de données personnalisée

- Fonctionne bien pour des tâches de recherche répétitives

- Utile au-delà de LinkedIn seul

Inconvénients

- Nécessite du temps de mise en place

- Trop complexe pour de simples listes d’amorces

Le meilleur pour Octoparse AI est idéale pour les équipes opérationnelles et de recherche qui souhaitent le scraping Linkedin comme partie intégrante de flux de travail internes reproductibles, pas seulement pour l’export principal.

3. Evaboot

Evaboot est conçu uniquement pour les utilisateurs de Linkedin Sales Navigator. Sa principale valeur n’est pas la rapidité, mais la qualité des données. L’outil se concentre sur l’exportation de prospects propres, formatés et prêts à l’emploi.

Caractéristiques principales

- Export en un clic depuis les recherches Sales Navigator

- Nettoyage automatique des titres de poste, noms et symboles

- Détection de pistes incompatibles ou non pertinentes

- Découverte par e-mail avec vérification

- Des limites quotidiennes intégrées pour réduire le stress du compte

Avantages

- Sorties CSV très propres

- Installation minimale et faible taux d’erreur

- Réduit le travail de nettoyage manuel

Inconvénients

- Nécessite un Sales Navigator

- Exportation limitée de plomb à l’extérieur

Le meilleur pour Evaboot est idéal pour les équipes de vente B2B et de recrutement qui s’appuient fortement sur Sales Navigator et souhaitent des listes de prospects prêtes à l’emploi sans étapes de nettoyage supplémentaires.

4. PhantomBuster

PhantomBuster est une plateforme d’automatisation basée sur le cloud. Le scraping Linkedin n’est qu’une partie de ce qu’il fait. La véritable valeur réside dans l’enchaînement de plusieurs actions en flux de travail répétables.

Caractéristiques principales

- Extraction de profils, résultats de recherche, participants à l’événement et interactions de publication

- Exécution cloud avec exécutions planifiées

- Enchaînement de flux de travail sur plusieurs actions

- CRM et intégrations de tableaux Excel

Avantages

- Logique d’automatisation très flexible

- Pas besoin de laisser un appareil local fonctionner

- Adapté aux campagnes récurrentes

Inconvénients

- Demande du temps d’apprentissage

- Échelles tarifaires selon l’utilisation

Le meilleur pour PhantomBuster est idéal pour les équipes de croissance et marketing qui souhaitent automatiser la découverte de prospects chaque semaine ou quotidiennement, et non seulement une seule réception.

Linked Helper est un outil d’automatisation Linkedin basé sur ordinateur qui inclut le scraping LinkedIn dans le cadre d’un système de sensibilisation plus large. Il se concentre sur la simulation du comportement humain et le contrôle du timing des actions.

Caractéristiques principales

- Extraction des données de profil vers CSV

- Séquences de sensibilisation en plusieurs étapes

- Système intégré de gestion des prospects

- Découverte par e-mail avec crédits mensuels

Avantages

- Fonctionne sur plusieurs types de comptes LinkedIn

- Contrôle détaillé des délais et des limites

- Automatisation forte de la sensibilisation

Inconvénients

- Ça nécessite que l’ordinateur reste allumé

- La mise en place initiale peut sembler complexe

Le meilleur pour LinkedIn Helper est idéal pour les recruteurs et les équipes commerciales qui souhaitent du scraping + de la communication dans un environnement de bureau contrôlé.

6. TexAu

TexAu est une grande boîte à outils d’automatisation utilisée pour le scraping Linkedin et les flux de travail multiplateformes. Il est conçu pour les utilisateurs souhaitant connecter les données Linkedin à d’autres outils.

Caractéristiques principales

- Grande bibliothèque d’automatisations prêtes à l’emploi

- Découverte et vérification des e-mails

- Intégrations CRM et Zapier

- Options d’exécution cloud et de bureau

Avantages

- Pipelines puissants à plusieurs étapes

- Fonctionne sur de nombreuses plateformes

Inconvénients

- L’interface n’est pas adaptée aux débutants

- La tarification basée sur le temps peut rapidement s’épuiser

Le meilleur pour TexAu est idéal pour les utilisateurs avancés et les agences qui construisent des pipelines complexes de génération de prospects sur plusieurs plateformes.

7. Capitaine Data

Captain Data est conçu pour des flux de travail Linkedin structurés et reproductibles au niveau de l’équipe et de l’entreprise.

Caractéristiques principales

- Des dizaines d’actions d’extraction spécifiques à LinkedIn

- Filtrage avancé (effectif, croissance, rôles)

- Rotation des comptes et contrôles de sécurité

- Google Sheets et synchronisation CRM

Avantages

- Forte fiabilité pour les équipes

- Bonne gestion des erreurs

- Conçu pour l’échelle

Inconvénients

- Prix d’entrée plus élevé

- Moins flexible que les outils DIY

Le meilleur pour Captain Data est idéal pour les équipes RevOps et de croissance qui ont besoin d’un scraping Linkedin cohérent à grande échelle avec peu d’effort manuel.

8. Waalaxy

Waalaxy est un outil d’automatisation Linkedin adapté aux débutants qui inclut des fonctionnalités légères de scraping Linkedin . Il ne vise pas à extraire de grands ensembles de données. Au lieu de cela, il se concentre sur l’aide aux utilisateurs pour découvrir des prospects et gérer des flux de communication simples avec un minimum de configuration.

De nombreux freelances et petites entreprises choisissent Waalaxy car il supprime les barrières techniques. Vous pouvez commencer à prospecter en quelques minutes, même si vous n’avez jamais utilisé d’outils de raclage auparavant.

Caractéristiques principales

- Extension Chrome connectée directement à LinkedIn

- Extraction de base des données de profil et de résultats de recherche

- Séquences de sensibilisation Linkedin pré-construites

- Gestion simple des listes de prospects

- Communication par email optionnelle pour les forfaits plus élevés

Avantages

- Très facile à utiliser, même pour les utilisateurs non techniques

- Intégration rapide avec presque aucune configuration

- Bon équilibre entre automatisation et limites de sécurité

Inconvénients

- Contrôle limité de la logique de scraping

- Inadapté à la collecte de données à grande échelle

- Les flux de travail personnalisés sont restreints

Le meilleur pour Waalaxy est idéal pour les freelances, les fondateurs solo et les petites équipes qui souhaitent utiliser le scraping Linkedin principalement pour soutenir la prospection et la sensibilisation de base, pas l’analyse de données profonde.

9. Dux-Soup

Dux-Soup est l’un des outils d’automatisation Linkedin les plus anciens du marché. Il combine le scraping Linkedin avec des actions de sensibilisation telles que les visites de profils, les suivis et les campagnes de filtrage.

Parce qu’il existe depuis de nombreuses années, il est largement utilisé par les professionnels de la vente qui préfèrent une automatisation stable et prévisible plutôt que des fonctionnalités de pointe.

Caractéristiques principales

- Extraction des données de profil avec étiquetage et notes

- Campagnes goutte à goutte en plusieurs étapes (visiter, connecter, envoyer un message)

- Retards et limitation de l’énergie de type humain

- Intégrations CRM pour l’exportation de données extraites

- Support pour LinkedIn Basic, Sales Navigator et Recruiter

Avantages

- Outil mature et bien testé

- Un contrôle clair des limites et actions quotidiennes

- Fiable pour des campagnes de sensibilisation structurées

Inconvénients

- L’interface semble dépassée

- Ça peut ralentir la navigation sur LinkedIn

- Les modes de bureau ou navigateur nécessitent une configuration soigneuse

Le meilleur pour Dux-Soup est idéal pour les équipes commerciales et les chefs d’entreprise qui utilisent le scraping Linkedin dans le cadre de campagnes de sensibilisation répétables et valorisent la stabilité plutôt que la logique d’automatisation avancée.

Dripify est une plateforme d’automatisation Linkedin basée sur le cloud conçue pour les équipes qui souhaitent que les campagnes s’exécutent en continu. Le scraping LinkedIn est principalement utilisé ici pour alimenter des séquences de diffusion en permanence, plutôt que pour des exportations massives de données.

Parce qu’il fonctionne dans le cloud, Dripify élimine le besoin de garder un ordinateur en ligne, ce qui est une des principales raisons pour lesquelles de nombreuses équipes s’y tournent.

Caractéristiques principales

- Automatisation Linkedin hébergée dans le cloud

- Extraction des données de profil et de résultats de recherche

- Campagnes conditionnelles à goutte avec retards

- Simulation du comportement humain pour réduire le risque de détection

- Rôles d’équipe et autorisations sur des plans supérieurs

Avantages

- Les campagnes tournent 24h/24 et 7j/7 sans appareils locaux

- Interface épurée et moderne

- Facile à gérer plusieurs membres d’équipe

Inconvénients

- Les prix augmentent à mesure que l’utilisation augmente

- Flexibilité limitée dans la conception des flux de travail

- Non conçu pour l’enrichissement profond des données

Le meilleur pour Dripify est idéal pour les équipes commerciales et les agences qui utilisent le scraping Linkedin pour soutenir des campagnes sortantes en continu, surtout lorsque la fiabilité et la disponibilité comptent plus que le volume brut de données.

11. Voici Alfred

Meet Alfred est une plateforme sortante multicanal qui utilise le scraping Linkedin comme source de données pour la communication commerciale. Au lieu de se concentrer sur le volume brut des données, cela aide les équipes à transformer les prospects Linkedin en campagnes structurées via Linkedin, l’email et X (Twitter).

Il est souvent choisi par des utilisateurs qui souhaitent moins d’outils et un seul endroit pour gérer les conversations.

Caractéristiques principales

- Extraction de profils LinkedIn et de données de recherche

- Demandes de connexion automatisées et suivis

- Campagnes multi-canaux (Linkedin, email, X)

- Tableau de bord intégré pour la gestion des prospects et l’analyse

- Exécution dans le cloud

Avantages

- Vue unifiée des prospects et des conversations

- Suivi facile des campagnes pour les équipes

- Aucune configuration locale n’est requise

Inconvénients

- Personnalisation limitée de la campagne

- Problèmes occasionnels de réautorisation de compte

- Coût plus élevé comparé aux grattoirs à usage unique

Le meilleur pour Meet Alfred est idéal pour les équipes de vente et de marketing qui souhaitent utiliser le scraping Linkedin dans le cadre d’un système sortant multicanal, plutôt que de simplement exporter des données.

12. La Machine Growth

La Growth Machine est un outil de prospection axé sur la relation. Il utilise le scraping Linkedin pour identifier les prospects, puis se concentre sur leur échauffement avant la communication. Cela inclut les likes, les abonnements et les contacts multicanaux.

Il est conçu pour des réponses de qualité, pas pour un volume massif.

Caractéristiques principales

- Extraction de prospects et entreprises par LinkedIn

- Séquences multi-canaux (Linkedin, email, X)

- Enrichissement par e-mail avec plusieurs sources de vérification

- Actions de réchauffement social avant le contact

- Boîte de réception unifiée pour toutes les réponses

Avantages

- Taux de réponse élevés grâce à la logique de réchauffement

- Bon équilibre entre automatisation et personnalisation

- Fonctionne bien pour les flux de travail des agences

Inconvénients

- Plus complexe que les outils de base

- La tarification est basée sur l’identité, pas par utilisateur

- Ce n’est pas idéal pour des volumes de leads très importants

Le meilleur pour La Growth Machine est idéal pour les agences et les équipes sortantes qui veulent transformer le scraping LinkedIn en conversations de haute qualité, pas en décharges froides.

13. Surfe

Surfe aborde Linkedin en scraping différemment. Au lieu d’exporter de gros fichiers CSV, il se concentre sur l’enrichissement CRM en temps réel. Les profils LinkedIn deviennent des enregistrements CRM en direct.

Cela fait en sorte que tout soit plus axé sur la précision que sur l’échelle.

Caractéristiques principales

- Synchronisation en un clic de LinkedIn vers CRM

- Enrichissement vérifié des numéros d’adresse e-mail et de téléphone

- Mises à jour automatiques lorsque les profils changent d’emploi

- Travaille avec de grands CRM comme HubSpot et Salesforce

Avantages

- Données très propres et précises

- Réduit les mises à jour manuelles du CRM

- Utile pour les longs cycles de vente

Inconvénients

- Non conçu pour le grattage massif

- Limites d’utilisation quotidiennes sur les forfaits à bas prix

- Extension Chrome uniquement

Le meilleur pour Surfe est idéal pour les équipes commerciales avec des CRM actifs qui veulent que Linkedin scrape pour garder les dossiers précis et à jour, pas pour extraire des milliers de profils en même temps.

14. Données lumineuses

Bright Data est un fournisseur d’infrastructure de scraping de niveau entreprise. Il ne se concentre pas sur la facilité d’utilisation. Au contraire, il offre les outils nécessaires pour faire fonctionner le scraping Linkedin à très grande échelle.

Cela inclut les proxys, les API et les systèmes anti-blocage.

Caractéristiques principales

- API de scraping de profils LinkedIn, d’entreprise, d’emploi et de publications

- Grand réseau résidentiel, mobile et proxy d’accès à Internet

- CAPTCHA et gestion des blocs

- Parcours programmés et récurrents

- Des sorties structurées comme JSON et CSV

Avantages

- Extrêmement fiable à grande échelle

- Taux de réussite élevés pour les données publiques

- Forte focalisation sur la conformité

Inconvénients

- Nécessite une expertise technique

- Plus cher que la plupart des outils

- Pas adapté aux débutants

Le meilleur pour Bright Data est idéal pour les développeurs et les entreprises utilisant un scraping Linkedin à grande échelle pour l’analytique, l’étude de marché ou les produits de données.

ZenRows est une API de scraping axée sur les développeurs. Il simplifie le scraping Linkedin en gérant le rendu JavaScript, la rotation des proxy et les défis CAPTCHA en une seule requête. Il est conçu pour la rapidité d’intégration, pas pour les utilisateurs d’interface.

Caractéristiques principales

- Scraping Linkedin basé sur API

- Rendu JavaScript automatique

- Rotation proxy intégrée et gestion CAPTCHA

- Sortie de réponse structurée

Avantages

- Mise en place rapide pour les développeurs

- Pas besoin de gérer les proxys manuellement

- Bonne fiabilité pour le scraping de taille moyenne

Inconvénients

- Les coûts augmentent avec les fonctionnalités avancées

- Pas adapté aux utilisateurs non techniques

- Contrôles d’interface limités

Le meilleur pour ZenRows est idéal pour les startups et agences qui souhaitent implémenter le scraping via Linkedin via les API sans construire une infrastructure complète de scraping.

16. Derrick

Derrick est un outil de scraping Google Sheets – le premier Linkedin. Il est conçu pour les utilisateurs qui gèrent les leads directement dans des tableaux Excel plutôt que dans des CRM.

L’accent est mis sur la simplicité et la visibilité.

Caractéristiques principales

- Importez les profils LinkedIn et Sales Navigator dans les feuilles

- Enrichissement par email et données

- Déduplication automatique

- Extraction en temps réel

Avantages

- Très facile à utiliser

- Pas besoin de codage ni de configuration

- Ça fonctionne bien pour les petites équipes

Inconvénients

- Limité en dehors de Google Sheets

- Certaines fonctionnalités nécessitent des forfaits payants

- Non conçu pour l’automatisation à grande échelle

Le meilleur pour Derrick est idéal pour les commerciaux et recruteurs qui veulent que LinkedIn extraite directement les résultats dans Google Sheets avec une configuration minimale.

Scrapingdog est un service de scraping basé sur une API axé sur les données publiques Linkedin. Il est conçu pour l’échelle et la fiabilité plutôt que pour des flux de travail pilotés par l’interface utilisateur.

Caractéristiques principales

- API de profil LinkedIn et de récupération de tâches

- Blocage automatique et gestion du CAPTCHA

- Support des requêtes à haut volume

- Réponses JSON structurées

Avantages

- S’adapte bien à de grands ensembles de données

- Documentation API claire

- Bonne disponibilité pour un grattage continu

Inconvénients

- Nécessite des compétences techniques

- Les prix augmentent avec le volume

- Pas adapté aux utilisateurs occasionnels

Le meilleur pour Scrapingdog est idéal pour les équipes de données et les développeurs utilisant le scraping Linkedin pour l’analyse du marché du travail, le suivi des tendances ou de grands ensembles de données publics.

Risques du scraping par LinkedIn et comment les corriger

Après avoir choisi un outil, le prochain test de réalité est le risque. Le scraping Linkedin peut faire gagner des heures. Mais cela peut aussi entraîner des limites de comptes, des données désordonnées et des obstacles techniques. Si vous anticipez ces problèmes à l’avance, vous perdrez moins de temps et perdrez moins de comptes.

Bans potentiels de comptes et comment les éviter

Le plus grand risque dans le scraping sur LinkedIn est une restriction de compte. LinkedIn précise qu’il n’autorise pas les outils tiers qui extraient ou automatisent l’activité. Il peut restreindre les comptes lorsqu’il détecte une « activité automatisée » et demande aux utilisateurs de désactiver le logiciel ou les extensions concernés.

Comment réduire le risque (étapes pratiques) :

- Utilisez moins d’actions par jour. Les motifs rapides et répétables sont faciles à signaler. Espaces d’action et évite les « rafales ».

- Évitez les extensions risquées. LinkedIn mentionne explicitement les robots, robots, plug-ins et extensions qui extrachent ou automatisent l’activité comme étant interdit.

- Échauffez les nouveaux comptes. Un tout nouveau compte qui répelle soudainement des centaines de profils déclenche souvent des vérifications. Commencez petit et augmentez progressivement.

- Planifiez en fonction des limites de connexion. Les limites d’invitation sur LinkedIn sont strictes (de nombreuses sources citent environ ~100 par semaine pour de nombreux utilisateurs), donc le scraping + la sensibilisation devraient respecter ces limites.

Ce n’est pas seulement une question juridique ou politique. C’est un risque commercial. Si votre accès à LinkedIn est bloqué, votre équipe perd des pistes et de l’élan.

Préoccupations concernant la précision des données dans le scraping Linkedin

Même lorsque le scraping Linkedin « fonctionne », les données peuvent être erronées ou obsolètes. LinkedIn est généré par les utilisateurs. Les gens changent de métier, mettent à jour les titres, utilisent des emojis ou écrivent des rôles sous différents formats. Deux profils peuvent décrire le même poste avec des mots totalement différents.

Comment les équipes corrigent les problèmes de précision :

- Netoyez et normalisez les champs. Standardisez les titres (exemple : convertir « VP, Ventes 🇺🇸 » en « VP Ventes »).

- Déduplique les leads. La même personne peut apparaître dans plusieurs recherches.

- Vérifiez un échantillon par surprise. Examinez 20 à 50 lignes avant de faire confiance à 5 000 lignes.

- Privilégiez soigneusement les « signaux d’intention ». Les likes et commentaires peuvent être utiles, mais ils font aussi du bruit. Traitez-les comme des « intérêts possibles », pas comme une preuve.

Un bon processus de scraping Linkedin n’est pas seulement « exporter ». C’est export + clean + verify.

Défis techniques : gestion du contenu dynamique et du CAPTCHA

Les pages LinkedIn sont dynamiques. Une grande partie du contenu se charge avec JavaScript après l’ouverture de la page. Cela signifie que les racloirs simples peuvent « voir » des pages blanches ou manquer des champs. C’est pourquoi de nombreuses équipes utilisent des outils d’automatisation ou de rendu basés sur navigateur pour les sites très riches en JavaScript.

Puis vient le mur suivant : CAPTCHA et détection de bots. Quand un site pense que vous êtes automatisé, il peut vous ralentir, afficher du CAPTCHA ou bloquer les requêtes. Ces défenses sont courantes sur les sites modernes, surtout lorsque les demandes semblent répétitives ou arrivent trop rapidement.

Par exemple, votre grattoir fonctionne bien dès le premier jour, puis LinkedIn modifie la mise en page ou ajoute des vérifications supplémentaires. Soudain, votre script échoue, ou votre outil exporte la moitié des champs.

Comment réduire les pannes techniques :

- Attendez-vous à des changements de page. Préparez des étapes de scraping durables et testez fréquemment.

- Utilisez des outils qui gèrent JavaScript. Si la page est très axée sur JS, il faut un support de rendu.

- Ralentissez et ajoutez des retentions. Beaucoup de déclencheurs CAPTCHA proviennent de la vitesse et de motifs répétés.

En résumé, le scraping Linkedin n’est pas « régler et oublier ». C’est un processus qui nécessite un rythme, un nettoyage et une maintenance technique — surtout en 2026.

Pourquoi choisir les navigateurs DICloak Antidetect pour votre entreprise ?

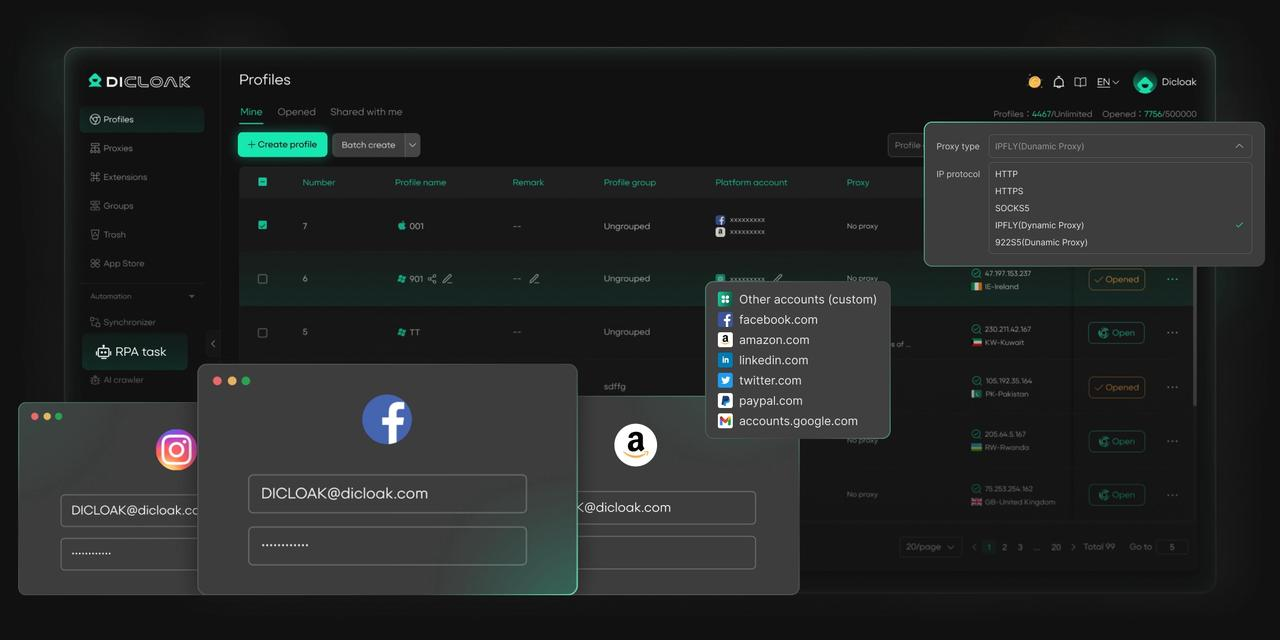

⚡Le navigateur antidétection DICloak est devenu un favori mondial pour sa capacité inégalée à gérer plusieurs comptes de manière efficace et sécurisée. Conçu pour les professionnels de la gestion des réseaux sociaux et plus encore, DICloak propose des fonctionnalités puissantes telles que l’automatisation RPA, les opérations en masse et un synchroniseur. De plus, il vous permet de personnaliser les empreintes digitales et d’intégrer des proxies pour chaque profil, garantissant une sécurité et une efficacité opérationnelle de haut niveau. C’est l’outil ultime pour des opérations fluides, sécurisées et évolutives.

Si votre travail nécessite plusieurs profils LinkedIn (par exemple, différents clients ou équipes), le plus grand risque est le lien entre comptes à partir de cookies partagés, de stockage local et d’empreintes digitales de navigateur. Un navigateur antidétection comme DICloak vous aide à exécuter des profils séparés avec un stockage et des signaux de périphérique isolés.

Qu’est-ce qui distingue DICloak ?

✅ Gérez 1 000+ comptes sur un seul appareil : Arrêtez de gaspiller de l’argent sur du matériel supplémentaire ! DICloak vous permet de gérer plusieurs comptes sur un seul appareil, réduisant ainsi les coûts et augmentant l’efficacité.

✅ Sécurité garantie des comptes, sans risques de bannissement : Chaque compte dispose de son propre profil navigateur isolé avec des empreintes digitales personnalisées et des adresses IP, réduisant considérablement le risque de bannissements. Vos comptes, votre contrôle !

✅ Configuration flexible du proxy pour des performances maximales : Intégrez sans problème avec tous les principaux protocoles proxy (HTTP/HTTPS, SOCKS5) et gérez votre pool de proxy avec des opérations en masse. Plus de difficultés avec la gestion de la propriété intellectuelle — DICloak a ce qu’il vous faut.

✅ Collaboration d’équipe simplifiée pour de meilleurs résultats : Gérez facilement votre équipe avec des outils avancés comme le partage de profil, les paramètres d’autorisation, l’isolement des données et les journaux d’opérations. Votre équipe travaille plus intelligemment, pas plus durement.

✅ Automatisez le grind avec RPA : le RPA intégré à DICloak vous fait gagner des heures de travail manuel. Automatisez les tâches répétitives, rationalisez les flux de travail et concentrez-vous sur ce qui compte vraiment : faire croître votre entreprise.

✅ Outils puissants de masse pour faire évoluer vos opérations : Créez, importez et lancez plusieurs profils navigateur en un seul clic. DICloak facilite la croissance de votre entreprise.

✅ Compatible avec tous les principaux systèmes d’exploitation : Basé sur le cœur Chrome, DICloak prend en charge la simulation des systèmes d’exploitation Windows, Mac, iOS, Android et Linux. Peu importe la plateforme dont vous avez besoin, DICloak a ce qu’il vous faut.

🔗 Prêt à commencer ?

Visitez le site web de DICloak pour en savoir plus et choisir le forfait qui vous convient. Commencez gratuitement dès aujourd’hui et découvrez la puissance d’une gestion multi-comptes sécurisée, efficace et évolutive !

Conclusion

Le scraping LinkedIn aide les équipes à collecter plus rapidement les données publiques Linkedin pour les ventes, le recrutement et la recherche. Mais cela comporte aussi des risques, tels que des limites de comptes, de mauvaises données et des problèmes techniques.

La façon la plus sûre d’utiliser le scraping Linkedin en 2026 est d’y aller doucement, de ne collecter que ce dont vous avez besoin, et de nettoyer vos données. Utilisez des outils fiables, évitez l’automatisation agressive et respectez les règles de LinkedIn. Si vous gérez plusieurs comptes, des outils comme DICloak peuvent aider à séparer les profils et à réduire les erreurs. Bien fait, le scraping sur LinkedIn peut être utile et durable sans mettre en danger vos comptes ou votre entreprise.

FAQ

Le scraping Linkedin est-il légal en 2026 ?

Le scraping LinkedIn peut être légal lors de la collecte de données publiques, mais il peut tout de même violer les Conditions d’utilisation de Linkedin. Les lois varient selon les pays, donc vérifiez toujours les règles locales.

Le scraping LinkedIn peut-il faire bannir mon compte ?

Oui. Un scraping rapide ou agressif sur LinkedIn peut déclencher des limites ou des bannissements. Utiliser de basses vitesses et des outils sûrs peut réduire les risques.

Quelles données sont sûres à collecter avec le scraping Linkedin ?

Uniquement les données publiques de profil, telles que le nom, le titre de poste, l’entreprise et la localisation. Évitez les informations privées ou sensibles.

Ai-je besoin de compétences techniques pour le scraping Linkedin ?

Pas toujours. Beaucoup d’outils sont adaptés aux débutants, mais le scraping basé sur API nécessite des connaissances techniques.

Que dois-je faire après un scraping Linkedin ?

Nettoie les données et importe-les dans un CRM. La valeur vient de la façon dont vous utilisez les données, pas seulement de la collecte.

Après le scraping Linkedin, les équipes nettoient et analysent généralement les données, puis les importent dans des systèmes CRM comme HubSpot ou Salesforce. Cela aide à la valorisation des prospects, à l’étude de marché et à la planification de la communication. Le scraping n’est que la première étape — la vraie valeur vient de la façon dont vous utilisez les données.

Outils gratuits

Extension de cookie

Générateur UA

Générateur d'adresse MAC

Générateur d'IP

Liste des adresses IP

Générateur de code 2FA

Horloge mondiale

Vérification Anonyme

Vérificateur de proxy

Vérificateur d'annonces FB

Extraction de données web par IA

Outils SMM gratuits

Vérificateur d'ombre bannissement Twitter